Deep Learning : Paradigma Pembelajaran yang Mengubah Dunia

Fondasi Deep Learning: Evolusi dari Kecerdasan Buatan

Definisi dan Posisi Deep Learning dalam Ranah AI

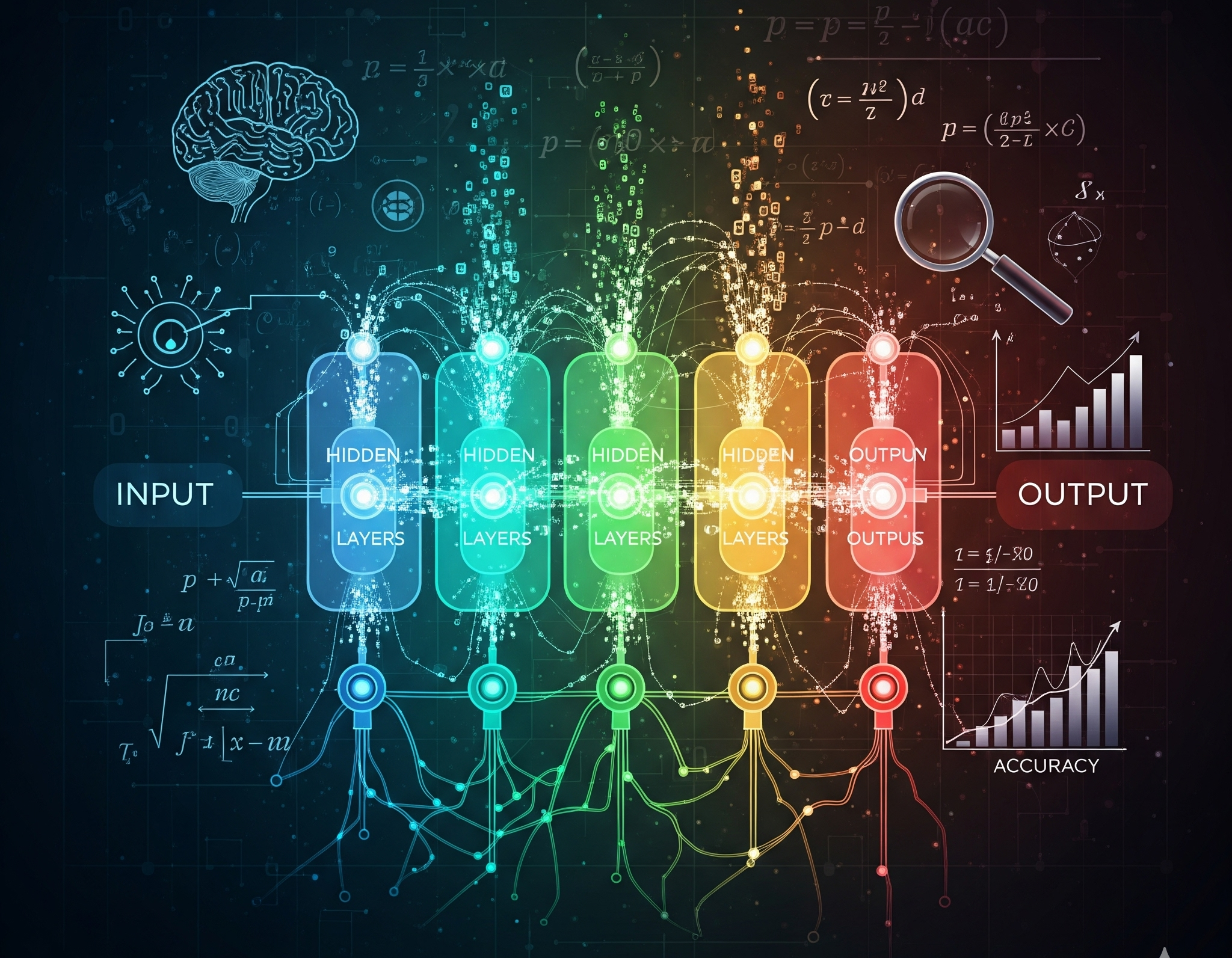

Deep learning, atau pembelajaran mendalam, merupakan cabang dari machine learning (ML) yang telah muncul sebagai salah satu pilar utama dalam bidang kecerdasan buatan (AI) modern. Secara fundamental, deep learning adalah pendekatan yang mengajarkan komputer untuk memproses data dengan cara yang terinspirasi oleh struktur dan fungsi otak manusia. Model-modelnya menggunakan jaringan saraf tiruan, yang terdiri dari banyak lapisan node (neuron) buatan yang saling terhubung. Berbeda dengan jaringan saraf tiruan sederhana yang memiliki satu atau dua lapisan, model deep learning dicirikan oleh penggunaan tiga atau lebih lapisan tersembunyi, bahkan sering kali mencapai ratusan atau ribuan lapisan, yang memungkinkan mereka untuk belajar representasi data yang sangat kompleks dan hierarkis.

Posisi deep learning dalam lanskap AI sering kali menjadi sumber kebingungan. Penting untuk dipahami bahwa deep learning bukanlah entitas yang terpisah, melainkan sebuah subset dari machine learning, yang pada gilirannya adalah subset dari kecerdasan buatan. Jaringan saraf tiruan menjadi struktur algoritmik spesifik yang membedakan deep learning dari teknik machine learning lainnya. Keunggulan deep learning terletak pada kemampuannya untuk mengenali pola-pola rumit dalam berbagai jenis data, termasuk gambar, teks, dan suara, yang memungkinkannya untuk menghasilkan wawasan dan prediksi yang sangat akurat.

Mengapa Deep Learning Berbeda: Perbandingan dengan Machine Learning Tradisional

Perbedaan antara deep learning dan machine learning tradisional adalah kunci untuk memahami mengapa deep learning begitu transformatif. Meskipun keduanya memiliki tujuan yang sama—mengidentifikasi pola dan membuat prediksi dari data—pendekatan mereka sangat berbeda, terutama dalam hal arsitektur, kebutuhan data, dan keterlibatan manusia.

Di tingkat paling dasar, perbedaan terletak pada arsitektur model. Algoritma machine learning tradisional, seperti regresi linier atau decision tree, memiliki struktur yang relatif sederhana dan transparan. Sebaliknya, deep learning dibangun di atas jaringan saraf tiruan multi-lapisan yang rumit dan saling terkait. Jaringan yang kompleks ini memungkinkan model untuk menangani tugas-tugas yang jauh lebih canggih.

Salah satu perbedaan paling krusial adalah dalam hal rekayasa fitur (feature engineering). Dalam machine learning tradisional, proses ini membutuhkan intervensi manusia yang signifikan. Seorang ahli harus secara manual memilih dan mengekstrak fitur-fitur yang relevan dari data mentah dan memberikan bobot pada fitur-fitur tersebut untuk dilatih oleh model. Misalnya, untuk memprediksi harga rumah, fitur-fitur yang relevan (seperti jumlah kamar, luas, dan lokasi) harus secara eksplisit didefinisikan oleh manusia.

Deep learning, di sisi lain, mengotomatisasi proses ini. Arsitektur jaringan saraf tiruan memungkinkan model untuk melakukan rekayasa fitur secara mandiri. Model deep learning dapat belajar untuk mengidentifikasi dan menciptakan representasi hierarkis dari data. Misalnya, dalam tugas pengenalan gambar, lapisan awal jaringan mungkin mendeteksi fitur-fitur sederhana seperti tepi dan garis. Lapisan-lapisan yang lebih dalam kemudian mengombinasikan fitur-fitur sederhana ini menjadi bentuk yang lebih kompleks, hingga akhirnya mengenali objek secara keseluruhan. Kemampuan untuk secara mandiri belajar abstraksi dari data ini, tanpa perlu campur tangan manusia yang eksplisit, adalah alasan mengapa deep learning jauh mengungguli machine learning tradisional dalam tugas pengenalan pola yang kompleks.

Selain itu, deep learning membutuhkan data dalam jumlah yang jauh lebih besar untuk berfungsi secara efektif, sering kali dalam jutaan titik data, dibandingkan dengan machine learning tradisional yang bisa bekerja dengan ribuan. Kebutuhan akan data yang masif ini memungkinkan model untuk menghilangkan fluktuasi dan membuat interpretasi berkualitas tinggi, yang pada akhirnya mengarah pada prediksi yang lebih akurat.

Secara ringkas, deep learning adalah pendekatan yang lebih canggih yang secara otomatis mengekstrak fitur, membuatnya sangat unggul dalam memproses data tidak terstruktur seperti gambar, teks, dan suara.

Tabel 1: Perbandingan Deep Learning vs. Machine Learning Tradisional

| Aspek | Deep Learning | Machine Learning Tradisional |

| Metodologi | Jaringan Saraf Tiruan Multi-lapisan | Algoritma Statistik atau Klasik (misalnya, Decision Tree, Regresi Linier) |

| Kebutuhan Data | Sangat besar (jutaan titik data) | Relatif kecil (ribuan titik data) |

| Rekayasa Fitur | Otomatis: Model mengekstrak fitur secara mandiri | Manual: Fitur harus dipilih dan diekstraksi oleh manusia |

| Jenis Data | Sangat cocok untuk data tidak terstruktur (gambar, teks, video, suara) | Lebih cocok untuk data terstruktur (angka, tabel) |

| Kompleksitas Model | Sangat kompleks, lapisan tersembunyi yang dalam | Relatif sederhana, kurang interpretatif |

| Interpretasi | Sulit diinterpretasikan (black box); membutuhkan Explainable AI (XAI) | Relatif mudah diinterpretasikan; model lebih transparan |

| Contoh Aplikasi | Pengenalan gambar, pemrosesan bahasa alami (NLP), mobil otonom | Sistem rekomendasi sederhana, deteksi spam email, prediksi harga |

Sejarah Singkat dan Tonggak Penting Deep Learning

Sejarah deep learning adalah narasi yang didorong oleh kebutuhan untuk mengatasi keterbatasan teknis dari model sebelumnya. Meskipun konsep jaringan saraf tiruan telah ada sejak lama, implementasi praktisnya hanya mungkin terjadi seiring dengan kemajuan komputasi. Beberapa tonggak penting menandai evolusi ini.

Pada tahun 1979, ide jaringan konvolusional mulai diperkenalkan. Namun, baru pada tahun 1985 algoritma backpropagation, yang menjadi kunci dalam melatih jaringan saraf, muncul dan secara signifikan meningkatkan akurasi. Tahun 1989 menjadi momen penting lain dengan adanya penerapan praktis yang mulai menunjukkan potensi model-model ini.

Pada era 1990-an hingga pertengahan 2010-an, fokus penelitian bergeser ke arsitektur untuk data sekuensial. Jaringan saraf berulang (RNN) sederhana, seperti Elman Network pada tahun 1990, menjadi arsitektur standar untuk pemodelan urutan. Meskipun secara teori mampu memproses data yang panjang, RNN menghadapi masalah fundamental yang dikenal sebagai masalah vanishing gradient. Masalah ini membuat bobot di lapisan awal jaringan hampir tidak pernah diperbarui, sehingga model kesulitan untuk “mengingat” informasi dari input yang jauh di masa lalu.

Keterbatasan ini mendorong penciptaan solusi yang lebih canggih. Pada tahun 1995, muncul Long Short-Term Memory (LSTM), sebuah varian RNN yang secara khusus dirancang untuk mengatasi masalah vanishing gradient. Dengan memperkenalkan “sel memori” dan “gerbang” yang mengontrol aliran informasi, LSTM secara efektif memungkinkan model untuk belajar dan mempertahankan dependensi jangka panjang dalam data sekuensial. Untuk waktu yang lama, LSTM menjadi arsitektur pilihan untuk tugas-tugas yang melibatkan data sekuensial yang panjang, seperti penerjemahan mesin.

Namun, LSTM masih memproses data secara sekuensial, satu per satu token pada satu waktu, yang membatasi efisiensi komputasi dan paralelisme, terutama pada unit pemrosesan grafis (GPU) yang semakin kuat. Keterbatasan ini adalah katalis untuk revolusi berikutnya. Pada tahun 2017, makalah berjudul “Attention Is All You Need” memperkenalkan arsitektur Transformer. Arsitektur ini secara fundamental meninggalkan unit rekurensi dan konvolusi, dan sebaliknya berfokus pada mekanisme self-attention untuk memproses seluruh urutan data secara paralel. Inovasi ini secara drastis mengurangi waktu pelatihan dan memungkinkan model untuk diskalakan pada kumpulan data yang sangat besar, secara langsung mengantarkan era baru dalam AI generatif dan model bahasa besar (LLMs).

Garis waktu ini menunjukkan bahwa perkembangan deep learning bukanlah serangkaian penemuan acak, tetapi sebuah narasi yang kohesif, di mana setiap arsitektur baru muncul sebagai respons terhadap kelemahan teknis dari arsitektur sebelumnya, dengan tujuan akhir untuk mencapai efisiensi, skalabilitas, dan kemampuan belajar yang lebih besar.

Anatomi Jaringan Saraf Tiruan dan Algoritma Pelatihan Inti

Konsep Dasar Jaringan Saraf Tiruan: Lapisan, Neuron, Bobot, dan Bias

Jaringan saraf tiruan (JST) adalah fondasi dari deep learning, dirancang untuk meniru cara otak manusia memproses informasi. Struktur JST terdiri dari node buatan yang disebut neuron, yang diatur dalam beberapa lapisan. Ada tiga jenis lapisan utama yang membentuk arsitektur ini:

- Lapisan Input (Input Layer): Lapisan pertama yang menerima data mentah. Setiap neuron di lapisan ini mewakili satu fitur dari data input.

- Lapisan Tersembunyi (Hidden Layers): Lapisan-lapisan yang berada di antara lapisan input dan output. Jaringan deep learning memiliki minimal satu, dan sering kali banyak lapisan tersembunyi. Lapisan-lapisan inilah yang melakukan sebagian besar komputasi dan secara hierarkis mengekstrak fitur dan pola dari data.

- Lapisan Output (Output Layer): Lapisan terakhir yang menghasilkan output akhir dari jaringan, yang bisa berupa prediksi, klasifikasi, atau keluaran lain yang diinginkan.

Hubungan antara neuron di setiap lapisan diatur oleh parameter yang disebut bobot (weights) dan bias. Bobot adalah nilai numerik yang menentukan seberapa kuat atau penting koneksi antara dua neuron. Sedangkan bias adalah nilai yang ditambahkan ke output setiap neuron untuk menyesuaikan hasilnya. Bobot dan bias adalah parameter yang dapat disesuaikan yang secara kolektif membentuk “pengetahuan” atau “program” dari jaringan. Tanpa parameter ini, jaringan hanyalah serangkaian perhitungan statis; proses pelatihan adalah proses untuk menemukan nilai bobot dan bias optimal yang meminimalkan kesalahan jaringan.

Mekanisme Kunci: Menjelaskan Algoritma Backpropagation secara Mendalam

Bagaimana sebuah jaringan saraf “belajar” untuk menyesuaikan bobot dan biasnya? Proses ini dimungkinkan oleh sebuah algoritma inti yang disebut backpropagation (propagasi balik). Algoritma ini merupakan metode pelatihan terbimbing (supervised learning) yang paling banyak digunakan untuk JST multi-lapisan. Tujuannya adalah untuk menyesuaikan bobot dan bias berdasarkan data pelatihan sehingga output yang dihasilkan semakin mendekati target yang diinginkan. Proses backpropagation terjadi dalam dua fase utama yang berulang:

- Fase Propagasi Maju (Forward Pass): Pada fase ini, data input dimasukkan ke lapisan input dan mengalir ke depan melalui jaringan. Di setiap neuron, sinyal input dari lapisan sebelumnya dikalikan dengan bobot koneksinya, dijumlahkan, dan ditambahkan dengan bias, lalu dilewatkan melalui fungsi aktivasi. Hasilnya menjadi input untuk lapisan berikutnya, dan proses ini berlanjut hingga output akhir dihasilkan oleh lapisan output.

- Fase Propagasi Mundur (Backward Pass): Setelah output dihasilkan, jaringan membandingkannya dengan output target yang diketahui. Selisih antara output yang diprediksi dan output target inilah yang disebut

error atau kesalahan. Algoritma backpropagation kemudian menyebarkan nilai error ini kembali (mundur) melalui jaringan, dari lapisan output ke lapisan tersembunyi. Mekanisme ini menggunakan aturan rantai dari kalkulus untuk menghitung seberapa besar kontribusi setiap bobot terhadap kesalahan total. Dengan kata lain, ia menentukan “tanggung jawab” setiap neuron dan koneksinya terhadap kesalahan yang terjadi.

Berdasarkan informasi error yang dipropagasi mundur, bobot dan bias disesuaikan sedikit demi sedikit dengan tujuan untuk mengurangi kesalahan. Seluruh proses ini—propagasi maju, perhitungan error, propagasi mundur, dan pembaruan bobot—diulang berkali-kali dalam siklus yang disebut epochs hingga kesalahan jaringan berada di bawah ambang batas yang dapat diterima.

Analogi yang membantu menjelaskan proses ini adalah dengan membayangkan seorang siswa yang sedang belajar. Dalam proses “propagasi maju,” siswa mencoba memecahkan masalah berdasarkan pengetahuan yang ada. Ketika ia mendapatkan jawaban yang salah, ia “mempropagasi mundur” kesalahan tersebut, menganalisis langkah-langkah mana yang salah, dan menyesuaikan pemahamannya di setiap langkah. Proses ini diulang hingga jawabannya benar. Dengan cara yang sama, backpropagation memungkinkan jaringan saraf untuk secara terus-menerus belajar dari kesalahannya sendiri, secara bertahap meningkatkan akurasinya dengan setiap iterasi.

Vanishing dan Exploding Gradient: Masalah Fundamental dalam Pelatihan Jaringan Saraf

Meskipun backpropagation adalah algoritma yang sangat kuat, ia tidak sempurna dan menghadapi tantangan signifikan, terutama pada jaringan yang sangat dalam. Dua masalah utama yang sering terjadi adalah vanishing gradient dan exploding gradient.

Masalah vanishing gradient adalah fenomena di mana gradien (turunan parsial dari fungsi kerugian) menjadi sangat kecil saat dipropagasi mundur melalui banyak lapisan. Hal ini terutama disebabkan oleh perkalian berulang dari gradien yang nilainya kurang dari satu, yang secara eksponensial mengurangi magnitudo gradien seiring dengan berjalannya proses mundur. Akibatnya, bobot dan bias di lapisan-lapisan awal jaringan hanya menerima pembaruan yang sangat kecil, membuat proses pelatihan menjadi lambat atau bahkan terhenti sama sekali. Jaringan pun kesulitan untuk belajar dari dependensi jangka panjang, yaitu hubungan antara input yang berada jauh di awal dengan output di akhir.

Masalah vanishing gradient secara fundamental membatasi kedalaman jaringan yang dapat dilatih dan menjadi kendala utama bagi arsitektur seperti RNN dalam memproses data sekuensial yang panjang. Keterbatasan inilah yang mendorong para peneliti untuk menciptakan solusi yang lebih canggih.

Long Short-Term Memory (LSTM), seperti yang dibahas di Bab 1, secara eksplisit dikembangkan untuk mengatasi masalah ini. Alih-alih mengandalkan satu hidden state sederhana, LSTM memperkenalkan “sel memori” dan “gerbang” yang mengontrol aliran informasi. Gerbang ini secara cerdas memutuskan informasi mana yang harus diingat dan mana yang harus dilupakan, sehingga gradien tetap stabil dan memungkinkan model untuk mempelajari dependensi jangka panjang.

Sebaliknya, masalah exploding gradient terjadi ketika gradien menjadi sangat besar selama propagasi mundur. Ini dapat menyebabkan pembaruan bobot yang sangat besar dan tidak stabil, yang pada akhirnya dapat membuat model gagal untuk menyatu atau belajar. Beberapa metode seperti gradient clipping (membatasi nilai gradien) digunakan untuk mengatasi masalah ini.

Munculnya masalah vanishing dan exploding gradient adalah contoh utama dari bagaimana keterbatasan teknis memicu inovasi arsitektur. LSTMs, yang muncul sebagai solusi langsung, menunjukkan bahwa evolusi deep learning adalah hasil langsung dari perjuangan teknis untuk mengatasi kelemahan-kelemahan fundamental dalam model-model yang ada.

Arsitektur-Arsitektur Dominan dalam Deep Learning

Deep learning telah melahirkan berbagai arsitektur jaringan saraf yang dirancang khusus untuk menangani jenis data dan masalah tertentu. Tiga arsitektur paling dominan, yang masing-masing mendefinisikan era dan domain aplikasi, adalah Jaringan Saraf Konvolusional (CNN), Jaringan Saraf Berulang (RNN), dan arsitektur Transformer.

Jaringan Saraf Konvolusional (CNN): Raja Visi Komputer

Jaringan Saraf Konvolusional, atau CNN, adalah arsitektur yang paling populer dan sangat efektif untuk masalah yang melibatkan data spasial, seperti gambar dan video. Keunggulan utama CNN terletak pada kemampuannya untuk secara otomatis mendeteksi fitur-fitur penting dalam data tanpa pengawasan manusia.

CNN dibedakan dari jaringan saraf lain oleh penggunaan lapisan konvolusional. Dalam lapisan ini, data input (misalnya, gambar) dipindai oleh sebuah filter. Filter ini adalah sebuah matriks nilai numerik acak yang, selama proses pelatihan, menyesuaikan nilainya secara otomatis untuk dapat mengenali fitur-fitur tertentu dalam data. Pada lapisan-lapisan awal, filter ini belajar untuk mendeteksi fitur-fitur sederhana seperti tepi, garis, atau kurva. Seiring data melewati lapisan-lapisan yang lebih dalam, filter-filter tersebut mulai mengenali pola-pola yang lebih kompleks dan abstrak, seperti bentuk, tekstur, atau bagian-bagian objek.

Setelah lapisan konvolusional, sering kali diikuti oleh lapisan pooling. Lapisan pooling berfungsi untuk mengurangi dimensi spasial dari peta fitur yang dihasilkan oleh lapisan konvolusional. Ini dilakukan dengan menggabungkan informasi dari wilayah-wilayah tertentu ke dalam representasi yang lebih kecil. Metode pooling yang umum adalah max pooling (mengambil nilai maksimum dari suatu wilayah) atau average pooling (mengambil rata-rata). Proses ini tidak hanya mengurangi kebutuhan komputasi dan memori, tetapi juga memperkenalkan properti yang disebut translation invariance. Artinya, jaringan menjadi tidak sensitif terhadap pergeseran kecil atau distorsi pada objek dalam gambar, memungkinkannya untuk mengenali objek tersebut terlepas dari posisinya yang sedikit berubah.

Pendekatan hierarkis dalam CNN secara langsung meniru cara sistem visual manusia memproses informasi. Lapisan-lapisan yang lebih dangkal menangkap detail-detail kecil, sementara lapisan-lapisan yang lebih dalam secara progresif mengagregasi detail-detail ini menjadi representasi yang lebih abstrak dan lebih tinggi. Tanpa arsitektur hierarkis ini, tugas pengenalan objek akan menjadi sangat tidak efisien dan tidak skalabel.

Jaringan Saraf Berulang (RNN) dan Evolusinya: Mengolah Data Sekuensial

Berbeda dengan CNN yang unggul dalam data spasial, Jaringan Saraf Berulang (RNN) dirancang khusus untuk memproses data sekuensial, atau data yang datang dalam urutan. Ini mencakup teks, ucapan, dan data deret waktu. Keunikan RNN adalah kemampuannya untuk “mengingat” informasi dari input sebelumnya untuk memengaruhi output saat ini. Dalam praktiknya, setiap node dalam RNN bertindak sebagai “sel memori” yang membawa informasi yang diproses sebelumnya ke langkah berikutnya dalam urutan.

Salah satu contoh paling sederhana dari fungsi RNN adalah sistem autocorrect. Ketika sebuah kata diketik, sistem menggunakan huruf-huruf yang telah diketik sebelumnya (informasi sekuensial) untuk memprediksi huruf berikutnya atau untuk mengoreksi kesalahan ejaan. Namun, seperti yang dibahas di Bab 2, RNN dasar menghadapi tantangan vanishing gradient yang membuatnya sulit untuk memproses urutan yang sangat panjang.

Untuk mengatasi masalah ini, Long Short-Term Memory (LSTM) diperkenalkan. LSTM adalah evolusi signifikan dari RNN yang menggunakan mekanisme “gerbang” (gates)—yaitu forget gate, input gate, dan output gate—untuk secara cerdas mengontrol aliran informasi yang masuk, keluar, dan disimpan dalam “sel memori”. Mekanisme ini secara efektif mencegah gradien menghilang, memungkinkan model untuk mempertahankan informasi penting dari langkah-langkah yang jauh di masa lalu. LSTM menjadi arsitektur pilihan untuk tugas-tugas NLP yang membutuhkan pemahaman konteks jangka panjang, seperti terjemahan dan analisis sentimen.

Meskipun LSTM memperbaiki masalah teknis dalam RNN, keterbatasan fundamentalnya tetap pada sifat pemrosesan yang sekuensial. Setiap token dalam urutan harus diproses satu per satu, secara berurutan, yang membatasi skalabilitas pada kumpulan data yang sangat besar dan menghambat paralelisme.

Arsitektur Transformer: Mekanisme Self-Attention dan Pengaruhnya pada AI Generatif

Arsitektur Transformer, yang diperkenalkan pada tahun 2017 dalam makalah revolusioner “Attention Is All You Need,” mengatasi keterbatasan RNN dan LSTM dengan cara yang radikal. Arsitektur ini secara keseluruhan menolak unit rekurensi dan konvolusi, dan sebaliknya bergantung sepenuhnya pada mekanisme yang disebut self-attention (perhatian diri).

Fitur utama Transformer adalah kemampuannya untuk memproses seluruh urutan data secara paralel, tidak sekuensial. Mekanisme self-attention memungkinkan model untuk menentukan hubungan dan relevansi antara setiap bagian dari urutan data secara simultan. Proses ini bekerja dengan menciptakan tiga vektor untuk setiap token dalam urutan: vektor query (Q), vektor key (K), dan vektor value (V). Model kemudian menghitung skor keselarasan antara vektor query satu token dengan vektor key dari semua token lainnya (menggunakan dot product). Skor ini kemudian dinormalisasi menjadi attention weights (bobot perhatian) yang menentukan seberapa penting setiap token lain bagi token yang sedang diproses.

Vektor-vektor value kemudian digabungkan, dengan bobot yang lebih besar diberikan pada vektor dari token-token yang dianggap paling relevan. Hasilnya adalah representasi kontekstual yang kaya dan terperinci untuk setiap token, yang mencerminkan hubungannya dengan seluruh urutan.

Kemampuan Transformer untuk memproses hubungan jarak jauh dan melakukan komputasi secara paralel secara masif adalah mengapa model bahasa besar (LLM) seperti GPT dan BERT dapat dilatih pada dataset yang sangat besar dan mencapai kinerja yang belum pernah terjadi sebelumnya. Ini adalah pergeseran dari “memori sekuensial” yang terbatas pada RNN ke “pemahaman kontekstual global” yang komprehensif. Pergeseran ini menjadi kunci mengapa Transformer kini menjadi arsitektur dominan di balik AI generatif.

Tabel 2: Perbandingan Arsitektur Deep Learning Utama

| Aspek | CNN | RNN/LSTM | Transformer |

| Kekuatan Utama | Sangat akurat untuk data spasial. Otomatisasi ekstraksi fitur hierarkis. | Mengolah data sekuensial. Mampu mengingat dependensi jangka panjang (LSTM). | Komputasi paralel yang masif. Efisien pada data sekuensial yang sangat panjang. Memahami konteks global. |

| Kelemahan Utama | Tidak efektif untuk data temporal. Kurang optimal untuk hubungan kontekstual yang kompleks. | Sulit untuk diparalelkan. Masalah vanishing gradient (RNN dasar). | Membutuhkan waktu komputasi yang kuadratik terhadap ukuran jendela konteks. |

| Kasus Penggunaan | Visi komputer (pengenalan objek, deteksi wajah), pengolahan video. | Pemrosesan bahasa alami (NLP) (terjemahan, analisis sentimen), autocorrect, prediksi deret waktu. | AI generatif (LLM, model teks-ke-gambar), penerjemahan mesin, ringkasan dokumen. |

| Mekanisme Kunci | Lapisan konvolusional dan filter. Lapisan pooling. | Unit rekurensi. Sel memori dan gerbang (gates) (LSTM). | Mekanisme self-attention dan multi-head attention. |

Spektrum Aplikasi: Dari Pemrosesan Teks hingga Penemuan Obat

Kemampuan deep learning untuk memproses data tidak terstruktur telah memungkinkan penerapannya yang luas di berbagai industri, mengubah cara manusia berinteraksi dengan teknologi, menganalisis informasi, dan menyelesaikan masalah kompleks.

Revolusi dalam Pemrosesan Bahasa Alami (NLP)

Pemrosesan Bahasa Alami (NLP) adalah domain di mana deep learning memiliki dampak yang paling terlihat. Teknologi ini memungkinkan mesin untuk memahami, menafsirkan, dan bahkan menghasilkan bahasa manusia dengan tingkat akurasi yang tinggi. Sejak kemunculan arsitektur Transformer dan model bahasa besar (LLM), NLP telah mengalami pergeseran paradigma dari analisis menjadi generasi.

Secara tradisional, aplikasi NLP berfokus pada tugas-tugas diskriminatif seperti mendeteksi spam email, mengklasifikasikan dokumen, atau membedakan makna kata berdasarkan konteks (word-sense disambiguation). Namun, dengan munculnya deep generative learning, teknologi ini kini mampu menciptakan output yang benar-benar baru dari input yang telah dipelajari. Inilah fondasi dari AI generatif modern , yang telah melahirkan aplikasi seperti chatbot layanan pelanggan , asisten virtual seperti Alexa , dan alat yang dapat menghasilkan artikel, laporan, atau konten kreatif berdasarkan perintah yang diberikan.

Di luar penggunaan sehari-hari, deep learning dalam NLP juga meningkatkan analisis data dengan memungkinkan ekstraksi wawasan dari data teks tidak terstruktur, seperti ulasan pelanggan, postingan media sosial, atau artikel berita. Ini memungkinkan bisnis untuk melakukan analisis sentimen, mengidentifikasi tren pasar, dan membuat keputusan yang didorong oleh data dengan lebih efisien.

Deep Learning di Bidang Kesehatan dan Biomedis: Diagnosis, Genomik, dan Penemuan Obat

Penerapan deep learning di bidang kesehatan dan biomedis menunjukkan potensi yang luar biasa untuk meningkatkan perawatan pasien, diagnosis, dan penelitian. Teknologi ini dapat menganalisis data pasien dalam jumlah besar, termasuk riwayat medis, hasil lab, dan pencitraan medis, untuk mengidentifikasi pola dan membuat diagnosis yang akurat. Dalam beberapa kasus, model deep learning bahkan mampu mendeteksi kelainan pada gambar medis yang mungkin tidak terlihat oleh mata manusia, sehingga mengurangi tingkat kesalahan diagnosis.

Selain diagnosis, deep learning juga merevolusi bidang genomik dan penemuan obat. Analisis genom manusia yang terdiri dari miliaran pasangan basa secara tradisional merupakan proses yang lambat dan tidak efisien. Namun, algoritma deep learning dapat menganalisis data genomik ini dengan cepat dan akurat, memungkinkan para peneliti untuk mengidentifikasi mutasi genetik yang terkait dengan penyakit seperti kanker. Dalam penemuan obat, deep learning mengubah proses yang sebelumnya memakan waktu dan mahal menjadi proses yang lebih terprediksi. Algoritma dapat memprediksi efikasi senyawa obat potensial dengan menganalisis struktur kimianya. Sebagai contoh, platform milik Deep Genomics, BigRNA, adalah foundation model pertama di dunia untuk terapi RNA yang telah belajar aspek-aspek fundamental biologi dan kimia, memungkinkannya untuk menemukan mekanisme biologis baru dan kandidat terapi yang tidak dapat ditemukan dengan pendekatan tradisional.

Dampak deep learning di bidang kesehatan tidak hanya terbatas pada peningkatan presisi, tetapi juga pada skala. Kemampuannya untuk menganalisis data biologis dalam jumlah besar dengan cepat dan akurat secara fundamental mengubah alur kerja penelitian, mempercepat pemahaman tentang masalah biologis yang kompleks dan mengarah pada penemuan pengobatan dan terapi baru.

Aplikasi Krusial Lainnya

Di luar NLP dan kesehatan, deep learning telah meresap ke dalam berbagai sektor lain:

- Visi Komputer: Deep learning adalah inti dari sistem pengenalan wajah, mobil otonom, dan deteksi objek dalam video pengawasan. Arsitektur CNN memungkinkan model untuk secara andal mengenali objek dan fitur dalam gambar, bahkan ketika objek tersebut terdistorsi atau terhalang sebagian.

- Keuangan: Industri keuangan menggunakan deep learning untuk menganalisis data pasar dan membuat prediksi tentang tren keuangan. Selain itu, model deep learning sangat efektif dalam mendeteksi pola yang mengindikasikan aktivitas penipuan, seperti transaksi kartu kredit yang tidak biasa.

- Hiburan: Platform streaming menggunakan deep learning untuk sistem rekomendasi konten, menganalisis pola tontonan pengguna untuk menyarankan film atau acara yang relevan.

Tabel berikut memberikan ringkasan praktis dari berbagai aplikasi deep learning.

Tabel 3: Contoh Aplikasi Deep Learning di Berbagai Industri

| Industri | Contoh Aplikasi | Arsitektur DL yang Relevan | Manfaat Utama |

| Kesehatan & Biomedis | Diagnosis medis berbasis gambar (misalnya, X-ray), penemuan obat, analisis genomik | CNN, Transformer | Peningkatan akurasi diagnosis, percepatan penelitian, dan penemuan terapi baru |

| Teknologi & Komunikasi | Asisten virtual (chatbots), penerjemahan mesin, filter spam | RNN/LSTM, Transformer | Otomatisasi tugas, peningkatan interaksi manusia-komputer |

| Otomotif | Mobil otonom (pengenalan lingkungan, deteksi objek) | CNN | Peningkatan keselamatan dan fungsionalitas kendaraan |

| Keuangan | Deteksi penipuan, analisis tren pasar, penentuan harga dinamis | ANN, GANs, RNN | Peningkatan keamanan, pengambilan keputusan yang didorong data |

| Hiburan & Media | Sistem rekomendasi konten, filter media sosial | CNN, RNN | Pengalaman pengguna yang lebih personal, konten yang relevan |

Tantangan, Kelemahan, dan Pertimbangan Etis

Meskipun potensi deep learning sangat besar, adopsinya yang meluas tidak lepas dari serangkaian tantangan teknis, ekonomi, dan etis yang signifikan.

Ketergantungan pada Data Besar dan Biaya Komputasi yang Tinggi

Salah satu hambatan paling menonjol dalam pengembangan deep learning adalah kebutuhan yang luar biasa akan data dan daya komputasi. Model deep learning membutuhkan data dalam jumlah besar untuk dilatih secara efektif, sering kali membutuhkan jutaan titik data untuk mencapai kinerja yang optimal. Ketergantungan ini membuat deep learning sulit diterapkan pada masalah di mana data yang relevan tidak melimpah.

Selain kebutuhan data, biaya komputasi yang terkait dengan pelatihan model deep learning yang canggih sangatlah tinggi. Perangkat keras khusus seperti GPU (Graphical Processing Unit) adalah tulang punggung dari deep learning karena kemampuannya untuk melakukan komputasi paralel secara masif. GPU kelas atas seperti NVIDIA A100 bisa berharga sekitar $15.000 per unit, dan sistem yang lengkap dengan beberapa GPU bisa mencapai $200.000 atau bahkan lebih. Biaya pelatihan model bahasa besar bisa mencapai jutaan dolar, menjadikannya usaha yang hanya bisa dijangkau oleh segelintir perusahaan teknologi besar dengan sumber daya finansial yang substansial.

Biaya ini tidak terbatas pada perangkat keras awal. Ada biaya operasional yang signifikan, termasuk konsumsi energi ($200-$1.000 per bulan untuk lingkungan riset canggih) dan biaya sumber daya manusia yang sangat terampil. Seorang arsitek AI senior dapat memiliki gaji tahunan yang sangat tinggi. Ketergantungan pada modal dan sumber daya yang besar ini secara efektif menciptakan hambatan masuk yang signifikan bagi para peneliti independen, startup, dan institusi kecil. Akibatnya, kekuatan untuk mengembangkan dan mengendalikan AI yang paling canggih cenderung terkonsentrasi di tangan segelintir entitas besar, yang menimbulkan pertanyaan tentang sentralisasi kekuasaan dan aksesibilitas teknologi.

Fenomena “Kotak Hitam” (Black Box) dan Kebutuhan akan Interpretasi (XAI)

Masalah black box mengacu pada kurangnya transparansi dan kemampuan untuk menginterpretasikan bagaimana model deep learning mencapai kesimpulan mereka. Arsitektur deep learning yang kompleks, dengan ratusan atau ribuan lapisan tersembunyi, membuat proses pengambilan keputusannya menjadi tidak jelas bahkan bagi para pengembang yang membangunnya. Data masuk, hasil keluar, tetapi mekanisme internalnya tetap menjadi misteri.

Kurangnya transparansi ini memiliki implikasi serius, terutama dalam aplikasi berisiko tinggi. Jika kendaraan otonom membuat keputusan yang tidak terduga yang menyebabkan kecelakaan, sifat black box dari sistem tersebut membuat tidak mungkin untuk melacak “pemikiran” sistem dan memahami mengapa keputusan itu dibuat. Tanpa kemampuan untuk memvalidasi atau memahami output model, kepercayaan terhadap sistem ini menjadi sulit untuk dibangun.

Untuk mengatasi dilema ini, muncul bidang Explainable AI (XAI) atau AI yang dapat dijelaskan. XAI adalah serangkaian proses dan metode yang dirancang untuk memungkinkan pengguna manusia memahami dan memercayai hasil yang dihasilkan oleh algoritma machine learning. Tujuannya adalah untuk menggambarkan akurasi, keadilan, dan potensi bias dari sebuah model. Berbagai pendekatan XAI ada, termasuk model direct XAI (white box) yang dirancang untuk dapat diinterpretasikan sejak awal, dan model post hoc yang berusaha untuk menjelaskan keputusan dari model black box setelah fakta.

Bias dalam Data dan Algoritma: Mengatasi Diskriminasi dalam AI

Model deep learning sangat rentan terhadap bias, yang dapat menghasilkan prediksi yang tidak akurat atau tidak adil. Bias ini sering kali berasal dari data pelatihan yang tidak representatif dari populasi dunia nyata. Ketika sebuah algoritma dilatih pada data yang secara historis merefleksikan prasangka manusia, model tersebut akan mempelajari dan mengabadikan prasangka tersebut dalam keputusannya.

Ada beberapa jenis bias yang dapat terjadi dalam AI:

- Selection Bias: Terjadi ketika data pelatihan tidak mewakili populasi nyata. Contohnya, sistem pengenalan wajah yang dilatih pada individu dengan kulit terang akan kesulitan mengidentifikasi orang dengan warna kulit yang lebih gelap.

- Confirmation Bias: Terjadi ketika sistem AI terlalu bergantung pada pola yang sudah ada dalam data, yang memperkuat prasangka historis. Contohnya, algoritma perekrutan yang belajar bahwa kandidat sukses di masa lalu didominasi oleh pria akan cenderung lebih menyukai pelamar pria di masa depan.

- Stereotyping Bias: Terjadi ketika sistem AI memperkuat stereotip berbahaya. Contohnya, model terjemahan yang secara konsisten mengasosiasikan kata “perawat” dengan kata ganti perempuan dan “dokter” dengan kata ganti laki-laki.

Masalah bias tidak hanya sekadar kegagalan teknis; ini adalah masalah etis yang mendalam. Algoritma deep learning yang bias dapat membuat keputusan diskriminatif dalam konteks yang berisiko tinggi, seperti layanan kesehatan, peradilan pidana, atau persetujuan pinjaman. Mengatasi bias ini memerlukan pendekatan multidisiplin yang melibatkan teknolog, pakar etika, dan pembuat kebijakan. Solusinya mencakup memastikan data yang beragam dan representatif, menggunakan alat pendeteksi bias, dan mempertahankan pengawasan manusia pada area pengambilan keputusan yang kritis di mana bias AI dapat memiliki implikasi serius.

Tren Terkini dan Prospek Masa Depan Deep Learning

Bidang deep learning terus berkembang pesat, didorong oleh kemajuan dalam komputasi dan penelitian. Tren terkini mengindikasikan pergeseran signifikan dalam fokus penelitian dan pengembangan.

Kebangkitan Model Generatif dan Model Fondasi (LLMs, Diffusion Models)

Salah satu tren paling berpengaruh adalah kebangkitan deep generative learning. Jika deep learning pada awalnya berfokus pada tugas-tugas diskriminatif—seperti mengklasifikasikan gambar atau memprediksi kategori—model generatif menandai pergeseran fundamental. Model-model ini berfokus pada penciptaan output baru dari input yang telah dipelajari. Model generatif adalah dasar dari AI Generatif modern, yang dapat menghasilkan teks, gambar, musik, atau bahkan struktur molekul yang unik dan realistis.

Fenomena ini ditenagai oleh foundation models, yang merupakan model machine learning yang sangat besar dan dilatih pada kumpulan data yang luas. Mereka belajar aspek-aspek fundamental dari suatu domain, yang kemudian dapat diterapkan ke berbagai tugas yang berbeda. Model bahasa besar (LLMs) seperti GPT dan BERT adalah contoh foundation models yang dilatih pada dataset bahasa yang sangat besar. Namun, tren ini meluas jauh melampaui bahasa. Misalnya, foundation model BigRNA dilatih pada data biologis dan kimia, memungkinkannya untuk menemukan mekanisme biologis baru dan kandidat terapi RNA yang tidak dapat ditemukan dengan pendekatan tradisional.

Pergeseran dari “mengklasifikasikan” ke “menciptakan” ini mengubah peran AI dari sekadar alat analisis menjadi mitra kreatif dan penemuan.

Menuju Kecerdasan Buatan yang Lebih General: Tantangan dan Harapan

Meskipun model generatif saat ini sangat kuat, mereka masih memiliki keterbatasan. Para ahli menyebut fenomena jagged intelligence, di mana model dapat menjadi brilian dalam satu tugas, tetapi gagal dalam tugas lain yang tampaknya sederhana. Contohnya, model bahasa besar mungkin sangat mahir dalam menulis esai, tetapi kesulitan dalam mengeja kata-kata tertentu. Selain itu, ada masalah halusinasi, di mana model menghasilkan informasi yang salah atau tidak berdasar dengan keyakinan yang meyakinkan.

Penelitian saat ini berfokus pada pengembangan solusi untuk masalah-masalah ini, termasuk teknik seperti Uncertainty Quantification (UQ) untuk mengukur tingkat kepercayaan diri model dan pengembangan arsitektur modular yang lebih efisien. Arah lain yang menjanjikan adalah penggunaan Retrieval Augmented Generation (RAG), yang memungkinkan model untuk mengakses basis pengetahuan eksternal untuk mengurangi halusinasi dan meningkatkan akurasi.

Meskipun LLMs sangat canggih, mereka bukanlah entitas yang “berpikir” seperti manusia. Sebaliknya, mereka adalah mesin statistik yang sangat kompleks yang memprediksi kata berikutnya dalam sebuah urutan berdasarkan probabilitas yang dipelajari. Tantangan terbesar di masa depan adalah untuk bergerak dari “kecerdasan buatan sempit” yang berfokus pada tugas-tugas spesifik, menuju “kecerdasan buatan umum” (Artificial General Intelligence), yang dapat belajar dan bernalar lintas domain seperti manusia. Jalan menuju general AI masih panjang, tetapi setiap inovasi dalam deep learning membawa kita lebih dekat pada tujuan tersebut.

Kesimpulan

Analisis komprehensif ini menegaskan bahwa deep learning adalah paradigma pembelajaran otomatis yang mendefinisikan era modern kecerdasan buatan. Sebagai evolusi dari machine learning tradisional, deep learning membedakan dirinya melalui arsitektur jaringan saraf tiruan yang kompleks dan, yang paling penting, kemampuannya untuk mengotomatisasi rekayasa fitur. Transformasi ini memungkinkan model untuk secara hierarkis belajar abstraksi dari data, yang mengarah pada kinerja superior dalam memproses data tidak terstruktur seperti gambar, teks, dan suara.

Perkembangan arsitektur deep learning mengikuti sebuah narasi sebab-akibat: dari Jaringan Saraf Berulang (RNN) yang menghadapi masalah vanishing gradient, ke Long Short-Term Memory (LSTM) sebagai solusi parsial, dan akhirnya ke arsitektur Transformer yang merevolusi bidang ini dengan memungkinkan komputasi paralel dan pemahaman kontekstual global.

Dampak deep learning terlihat di berbagai sektor, mengubah industri dari perawatan kesehatan (melalui diagnosis berbasis gambar dan penemuan obat) hingga keuangan (melalui deteksi penipuan) dan komunikasi (melalui asisten virtual dan AI generatif). Namun, adopsi yang meluas tidak lepas dari tantangan. Ketergantungan pada data dalam jumlah besar dan biaya komputasi yang sangat tinggi secara efektif memusatkan kekuatan pengembangan AI di tangan segelintir entitas besar. Selain itu, sifat black box dari model deep learning menimbulkan pertanyaan kritis tentang kepercayaan dan akuntabilitas, yang mendorong kebutuhan akan bidang Explainable AI (XAI). Terakhir, model deep learning rentan terhadap bias yang berasal dari data pelatihan yang tidak representatif, yang dapat mengabadikan dan memperkuat ketidaksetaraan sistemik.

Post Comment