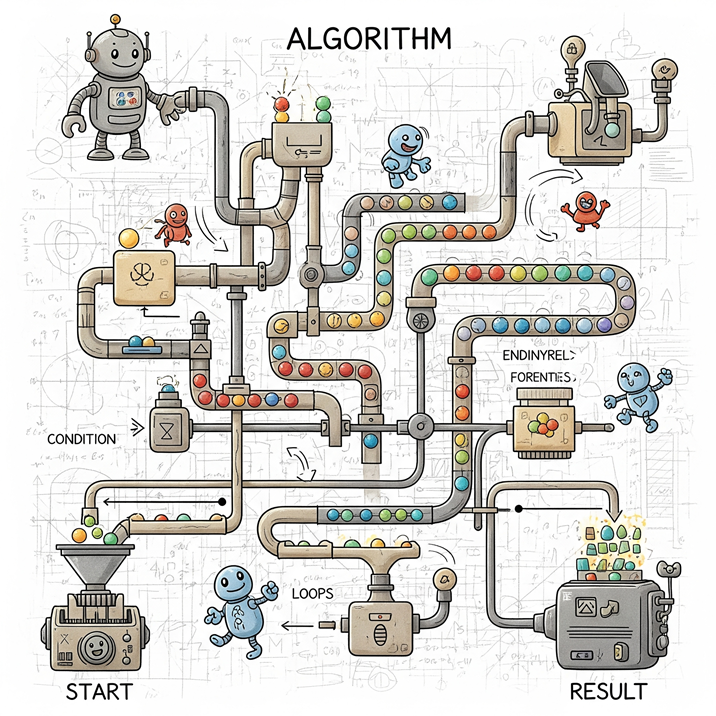

Memahami Algoritma sebagai Pilar Komputasi

Algoritma merupakan sebuah konsep fundamental yang menjadi fondasi dari seluruh disiplin ilmu komputer dan teknologi informasi. Analisis ini bertujuan untuk mendefinisikan, mengklasifikasikan, dan mengupas peran vital algoritma, dari asal-usul historisnya hingga aplikasi modern yang merevolusi berbagai bidang. Laporan ini akan membangun pemahaman yang komprehensif, dari kerangka teoretis hingga tantangan etika di masa depan.

Definisi Holistik Algoritma

Secara fundamental, algoritma didefinisikan sebagai serangkaian instruksi atau langkah-langkah yang disusun secara sistematis dan logis untuk menyelesaikan sebuah masalah, baik itu persoalan logika maupun matematika, seringkali dengan bantuan komputer. Definisi yang lebih sederhana menggambarkan algoritma seperti sebuah resep masakan, di mana serangkaian langkah yang terstruktur perlu diikuti untuk mencapai hasil yang diinginkan, seperti hidangan yang lezat. Dengan kata lain, algoritma adalah metode atau prosedur sistematis yang digunakan untuk memproses data atau menjalankan suatu operasi secara terstruktur untuk memecahkan masalah tertentu.

Karakteristik dan Sifat Fundamental

Untuk dianggap sebagai sebuah algoritma yang valid, sebuah prosedur harus memiliki beberapa karakteristik khusus. Menurut ahli, Donald E. Knuth, algoritma harus memiliki sifat keterbatasan (finiteness), yang berarti prosedur tersebut harus dapat menghasilkan solusi atau jawaban setelah menyelesaikan sejumlah langkah yang terbatas. Selain itu, algoritma juga harus memiliki masukan (input)—dengan jumlah nol atau lebih—dan keluaran (output)—dengan jumlah satu atau lebih. Setiap langkah dalam algoritma harus terdefinisi dengan jelas, logis, dan terurut, yang dikenal sebagai proses yang logis dan sistematis.

Salah satu sifat terpenting dari algoritma adalah universalitas notasi. Ini berarti notasi yang digunakan untuk menulis algoritma tidak bergantung pada bahasa pemrograman tertentu. Sifat ini menegaskan bahwa algoritma adalah sebuah konsep abstrak yang berfungsi sebagai cetak biru atau “nyawa” dari sebuah program, sementara bahasa pemrograman hanyalah “bahasa” yang digunakan untuk menerjemahkan dan mengeksekusi cetak biru tersebut di komputer. Sifat ini membuktikan bahwa algoritma adalah sebuah kerangka berpikir universal yang mampu menjembatani logika manusia dengan eksekusi mesin, memungkinkan sebuah solusi logis untuk diterapkan dalam berbagai konteks, baik teknis maupun non-teknis.

Fungsi dan Peran Kunci dalam Pemrograman dan Kehidupan Sehari-hari

Algoritma memegang peran krusial dalam memecahkan masalah secara logis dan sistematis, menjadi pilar utama dalam pengembangan perangkat lunak dan sistem digital. Fungsi utamanya mencakup menyederhanakan masalah yang kompleks dengan membaginya menjadi sub-masalah yang lebih kecil dan mudah dikelola, sebuah pendekatan yang dikenal sebagai Divide and Conquer. Bagi seorang programmer, algoritma juga sangat membantu dalam melacak dan men-debug kesalahan, karena langkah-langkah yang terdefinisi dengan jelas memungkinkan identifikasi masalah yang akurat. Selain itu, algoritma yang dirancang dengan baik memungkinkan modifikasi atau pembaruan program secara efisien tanpa harus mengubah keseluruhan strukturnya.

Lebih dari sekadar alat teknis, algoritma telah menjadi fondasi yang hampir tidak terlihat dari infrastruktur digital modern. Banyak implementasi algoritma ditemukan dalam kehidupan sehari-hari tanpa disadari. Sebagai contoh, algoritma pengurutan dan pencarian adalah pilar utama dari aplikasi-aplikasi sehari-hari seperti mesin pencari, platform e-commerce, sistem navigasi, dan basis data. Dari mencari rute tercepat di aplikasi peta hingga mengurutkan produk berdasarkan harga di toko daring, algoritma adalah elemen fundamental yang membentuk pengalaman digital sehari-hari, membuktikan relevansinya yang melampaui batas akademis dan teknis.

Landasan Sejarah dan Tokoh-tokoh Kunci

Sejarah algoritma adalah sebuah narasi evolusi konseptual dari metode perhitungan manual menjadi prosedur yang dapat dieksekusi oleh mesin. Perjalanan ini melibatkan kontribusi dari beberapa pemikir dan matematikawan terkemuka yang meletakkan fondasi bagi komputasi modern.

Asal-usul Terminologi: Dari Al-Khawarizmi hingga Algorism

Istilah “algoritma” memiliki asal-usul yang kaya dan rumit, tidak muncul dalam kamus hingga pertengahan abad ke-20. Terminologi ini berasal dari nama seorang matematikawan dan astronom Muslim Persia yang terkemuka, Abu Ja’far Muhammad Ibnu Musa Al-Khawarizmi. Di Eropa, nama Al-Khawarizmi dikenal dalam bentuk Latin, Algorismus, yang awalnya merujuk pada aktivitas berhitung menggunakan sistem bilangan Arab yang ia perkenalkan. Nama ini kemudian berevolusi menjadi “algoritma” dan digunakan untuk menyebut konsep sistematis yang ia temukan.

Kontribusi Penting

Abu Ja’far Muhammad Ibnu Musa Al-Khawarizmi

Al-Khawarizmi tidak hanya diakui sebagai “Bapak Algoritma” tetapi juga “Bapak Aljabar”. Karyanya yang berjudul Al-Kitāb al-jabr wa-l-muqābala menjadi fondasi aljabar dan memperkenalkan metode sistematis untuk menyelesaikan persamaan linear dan kuadrat. Ia juga berkontribusi besar dalam memperkenalkan sistem bilangan Hindu-Arab ke dunia Barat, termasuk penggunaan angka 1-9 dan 0, yang menjadi dasar aritmetika modern.

Leonardo Fibonacci

Pada abad ke-13, seorang matematikawan Italia, Leonardo Fibonacci, berperan penting dalam menyebarkan sistem bilangan Hindu-Arab ke Eropa melalui bukunya Liber Abaci. Ia secara aktif mempromosikan penggunaan algoritma aritmetika, yang secara fundamental mengubah metode perhitungan dalam matematika dan perdagangan di benua tersebut. Kontribusi Fibonacci membantu mengintegrasikan metode-metode baru yang lebih efisien ke dalam praktik sehari-hari, membuka jalan bagi perkembangan yang lebih besar.

Alan Turing

Jauh di abad ke-20, Alan Turing meletakkan fondasi formal bagi algoritma modern. Melalui makalahnya pada tahun 1936, ia memperkenalkan konsep teoretis Mesin Turing, sebuah model abstrak untuk komputasi. Mesin ini dirancang untuk dapat menjalankan algoritma apa pun yang dapat dipecahkan, dan konsepnya menjadi dasar bagi seluruh teori komputasi dan cara kerja komputer digital saat ini.

Perjalanan historis ini memperlihatkan pergeseran yang mendasar dari algoritma sebagai sebuah metode perhitungan manual untuk manusia, seperti yang diperkenalkan oleh Al-Khawarizmi dan disebarkan oleh Fibonacci, menjadi sebuah prosedur formal yang dapat dieksekusi secara otomatis oleh mesin, seperti yang digagas oleh Alan Turing. Transformasi paradigma ini menjadi landasan bagi revolusi digital yang terus berlanjut hingga kini.

Klasifikasi dan Tipe Algoritma Utama

Algoritma dapat diklasifikasikan berdasarkan berbagai kriteria, termasuk pendekatan yang digunakan untuk memecahkan masalah dan fungsi utamanya. Pemahaman tentang klasifikasi ini sangat penting untuk memilih metode yang paling efisien untuk sebuah tugas tertentu.

Algoritma Berdasarkan Pendekatan Pemecahan Masalah

- Algoritma Rekursif: Algoritma ini memecahkan masalah dengan memanggil dirinya sendiri secara berulang untuk menyelesaikan sub-masalah yang lebih kecil, hingga mencapai sebuah kondisi dasar (base case) yang menghentikan proses.

- Algoritma Divide and Conquer: Pendekatan ini memecah masalah besar menjadi sub-masalah yang lebih kecil dan mudah dikelola, menyelesaikannya secara rekursif, dan kemudian menggabungkan solusi dari setiap sub-masalah untuk membentuk solusi akhir. Contoh klasik dari pendekatan ini adalah Merge Sort dan Quick Sort.

- Algoritma Greedy: Algoritma ini membuat keputusan lokal terbaik di setiap langkah dengan harapan bahwa keputusan tersebut akan mengarah pada solusi global yang optimal. Meskipun efisien, algoritma ini tidak selalu menjamin solusi optimal untuk semua masalah.

- Algoritma Brute Force: Metode ini mencoba semua kemungkinan solusi secara langsung untuk menemukan jawaban yang benar. Meskipun mudah diterapkan dan menjamin solusi yang benar, metode ini seringkali sangat tidak efisien dan memakan banyak waktu dan sumber daya.

- Algoritma Backtracking: Teknik ini digunakan untuk menyelesaikan masalah yang melibatkan pilihan dengan mencoba berbagai kemungkinan solusi dan “mundur” ketika sebuah jalur tidak mengarah pada solusi yang benar.

Algoritma Berdasarkan Fungsi Utama

- Algoritma Pengurutan (Sorting): Tujuan utama dari algoritma ini adalah untuk mengubah data yang tidak teratur menjadi urutan yang teratur, baik menaik (ascending) maupun menurun (descending). Terdapat berbagai metode pengurutan, masing-masing dengan keunikannya.

- Bubble Sort: Bekerja dengan membandingkan elemen-elemen berpasangan yang berdekatan dan menukarnya jika diperlukan, hingga seluruh elemen berada dalam urutan yang benar.

- Quick Sort: Menggunakan pendekatan Divide and Conquer dengan memilih sebuah elemen ‘pivot’, mempartisi array menjadi dua sub-array (elemen yang lebih kecil dan lebih besar dari pivot), dan kemudian mengurutkan sub-array tersebut secara rekursif. Algoritma ini dikenal sangat efisien dalam praktiknya.

- Merge Sort: Juga menggunakan Divide and Conquer dengan membagi daftar menjadi dua bagian, mengurutkan setiap bagian secara terpisah, dan kemudian menggabungkannya kembali. Algoritma ini dikenal efisien untuk data berukuran besar.

- Algoritma Pencarian (Searching): Algoritma ini digunakan untuk menemukan posisi atau keberadaan elemen tertentu dalam sebuah kumpulan data.

- Linear Search: Metode paling sederhana yang memeriksa setiap elemen dalam kumpulan data secara berurutan hingga elemen yang dicari ditemukan.

- Binary Search: Algoritma yang jauh lebih efisien untuk data yang sudah terurut. Ia bekerja dengan membagi data menjadi dua bagian, membandingkan elemen tengah dengan elemen yang dicari, dan secara rekursif mencari di salah satu bagian yang relevan.

- Algoritma Graf (Graph Traversal): Digunakan untuk menelusuri setiap node dalam struktur data graf. Contohnya termasuk Depth-First Search (DFS).

Tabel berikut menyajikan perbandingan kinerja beberapa algoritma pengurutan umum, yang menyoroti pentingnya memilih algoritma yang sesuai dengan situasi data yang akan diolah.

| Algoritma | Cara Kerja (Ringkas) | Kompleksitas Waktu (Terbaik) | Kompleksitas Waktu (Rata-rata) | Kompleksitas Waktu (Terburuk) | Kompleksitas Ruang |

| Bubble Sort | Membandingkan dan menukar elemen-elemen berpasangan yang berdekatan secara berulang | O(n) | O(n2) | O(n2) | O(1) |

| Quick Sort | Memilih ‘pivot’, mempartisi array, dan mengurutkan secara rekursif | O(nlogn) | O(nlogn) | O(n2) | O(logn) hingga O(n) |

| Merge Sort | Membagi data menjadi dua, mengurutkan, dan menggabungkan hasilnya | O(nlogn) | O(nlogn) | O(nlogn) | O(n) |

Analisis Efisiensi dan Kompleksitas Algoritma

Algoritma yang baik tidak hanya harus benar, tetapi juga efisien. Analisis efisiensi algoritma adalah proses untuk mengukur seberapa baik sebuah algoritma dalam menyelesaikan masalah dengan mempertimbangkan waktu dan sumber daya yang dibutuhkan.

Pengantar Analisis Kompleksitas

Efisiensi sebuah algoritma diukur melalui kompleksitasnya, yang merupakan ukuran seberapa banyak komputasi yang diperlukan. Analisis ini membantu membedakan dan memilih algoritma yang paling efisien di antara berbagai solusi untuk masalah yang sama. Meskipun algoritma yang sama mungkin menunjukkan kinerja yang berbeda pada arsitektur mesin yang berbeda, model pengukuran kompleksitas dirancang untuk independen dari platform tertentu.

Kompleksitas Waktu (Time Complexity) dan Ruang (Space Complexity)

Ada dua jenis kompleksitas utama yang digunakan dalam analisis algoritma:

- Kompleksitas Waktu (T(n)): Diukur dari jumlah tahapan komputasi yang dibutuhkan untuk menjalankan algoritma sebagai fungsi dari ukuran masukan (n). Ini menentukan laju peningkatan waktu yang diperlukan seiring dengan bertambahnya ukuran data yang diproses.

- Kompleksitas Ruang (S(n)): Diukur dari jumlah memori yang digunakan oleh struktur data dalam algoritma sebagai fungsi dari ukuran masukan (n).

Sebuah tren yang signifikan telah terjadi dalam analisis kompleksitas. Materi penelitian menunjukkan bahwa seiring dengan kemajuan teknologi yang menyediakan kapasitas memori yang semakin besar, kekritisan dari kompleksitas ruang menjadi berkurang. Pergeseran ini menyebabkan kompleksitas waktu menjadi metrik yang paling utama dan sering kali menjadi fokus tunggal dalam mengevaluasi efisiensi sebuah algoritma. Hal ini mencerminkan bagaimana kemajuan teknologi perangkat keras secara langsung memengaruhi metodologi analisis dalam ilmu komputer.

Notasi Big O (O-Besar) sebagai Ukuran Asimptotik

Untuk menggambarkan kompleksitas algoritma secara formal dan tidak bergantung pada mesin atau bahasa pemrograman, digunakan notasi asimptotik, dengan Notasi Big O (O) menjadi yang paling umum. Notasi ini secara spesifik mendeskripsikan kinerja algoritma dalam kasus terburuk ( worst-case scenario), memberikan batas atas pada waktu eksekusi seiring dengan pertumbuhan ukuran masukan (n).

Beberapa bentuk umum dari notasi Big O meliputi:

- O(1): Waktu konstan. Waktu eksekusi tidak dipengaruhi oleh ukuran masukan.

- O(n): Waktu linier. Waktu eksekusi berbanding lurus dengan ukuran masukan.

- O(n2): Waktu kuadratik. Waktu eksekusi meningkat sebanding dengan kuadrat ukuran masukan. Jenis algoritma ini umumnya hanya cocok untuk masukan berukuran kecil.

- O(logn) dan O(nlogn): Waktu logaritmik. Waktu eksekusi meningkat jauh lebih lambat daripada ukuran masukan. Algoritma ini biasanya ditemukan pada pendekatan Divide and Conquer seperti Binary Search dan Merge Sort.

Studi Kasus: Analisis Kasus Terbaik, Terburuk, dan Rata-rata

Analisis algoritma seringkali dilakukan untuk tiga skenario yang berbeda: Kasus Terbaik (Best Case), Kasus Terburuk (Worst Case), dan Kasus Rata-rata (Average Case). Analisis ini memberikan gambaran yang lebih lengkap tentang kinerja algoritma dalam berbagai situasi. Sebagai contoh, algoritma Insertion Sort memiliki kompleksitas waktu O(n) pada kasus terbaik (ketika array sudah terurut), tetapi memiliki kompleksitas waktu O(n2) pada kasus terburuk (ketika array terurut secara terbalik). Sementara itu, algoritma Quick Sort memiliki kompleksitas waktu rata-rata O(nlogn), namun dapat merosot ke O(n2) dalam kasus terburuk. Di sisi lain, Merge Sort memiliki kompleksitas waktu yang stabil O(nlogn) untuk semua kasus, menjadikannya pilihan yang andal untuk data yang besar. Analisis ini menunjukkan bahwa pilihan algoritma harus mempertimbangkan tidak hanya fungsionalitasnya tetapi juga bagaimana kinerjanya akan bervariasi tergantung pada kondisi masukan data.

Algoritma di Era Modern: Aplikasi dan Revolusi

Di era digital kontemporer, algoritma telah menjadi pendorong utama di balik revolusi dalam kecerdasan buatan, ilmu data, dan keamanan siber. Algoritma memungkinkan sistem untuk memproses data dalam jumlah masif, memecahkan masalah kompleks, dan membuat keputusan otomatis dengan presisi yang sebelumnya tidak mungkin tercapai.

Peran Algoritma dalam Kecerdasan Buatan dan Ilmu Data

Kecerdasan buatan (AI) dan ilmu data (data science) sepenuhnya bergantung pada algoritma yang canggih. Sebuah cabang penting dari AI adalah Algoritma Pembelajaran Evolusioner (Evolutionary Algorithms), sebuah metode optimasi berbasis populasi yang terinspirasi oleh teori evolusi. Algoritma ini menghasilkan solusi dengan cara berevolusi melalui proses reproduksi, mutasi, dan seleksi hingga mencapai solusi yang optimal. Contohnya termasuk Algoritma Genetika, di mana solusi diwakili sebagai rangkaian angka, dan Pemrograman Genetik, di mana solusi diwakili dalam bentuk program komputer.

Penerapan algoritma machine learning (ML) semakin meluas di berbagai sektor industri. Algoritma seperti Random Forest dan XGBoost secara luas digunakan dalam analisis prediktif untuk bisnis, seperti meramalkan perilaku konsumen dalam e-commerce dan mengevaluasi risiko dalam fintech. Kemampuan mereka dalam menangani data besar dan variabel yang kompleks menjadikannya pilihan utama bagi para praktisi data. Selain itu, Reinforcement Learning (RL), khususnya model seperti Q-Learning, mulai diadopsi untuk mengembangkan sistem chatbot yang adaptif dan personal dalam layanan pelanggan.

Tabel berikut menunjukkan beberapa contoh aplikasi spesifik dari algoritma machine learning di berbagai sektor.

| Sektor Industri | Algoritma yang Digunakan | Penerapan Spesifik |

| E-commerce | Random Forest, XGBoost | Peramalan perilaku konsumen, sistem rekomendasi produk |

| Fintech | XGBoost, Regresi Logistik | Credit scoring, evaluasi risiko, deteksi transaksi mencurigakan |

| Layanan Pelanggan | Reinforcement Learning (Q-Learning) | Pengembangan chatbot adaptif yang belajar secara real-time |

| Manajemen Portofolio | Reinforcement Learning | Pengambilan keputusan investasi otomatis berdasarkan pola yang diperbarui |

Algoritma untuk Keamanan Siber dan Analisis Malware

Di bidang keamanan siber, algoritma telah menjadi alat yang sangat diperlukan, mulai dari deteksi ancaman hingga respons otomatis. Algoritma AI mampu menganalisis data dalam jumlah besar untuk mengidentifikasi pola mencurigakan dan mendeteksi potensi ancaman sebelum berkembang. Sistem berbasis AI juga dapat merespons ancaman secara otonom, seperti mengisolasi perangkat yang terinfeksi dan memblokir aktivitas berbahaya, sehingga mengurangi kerugian secara signifikan.

Beberapa algoritma pembelajaran mesin telah diterapkan secara spesifik untuk deteksi intrusi dan analisis malware. Algoritma Support Vector Machine (SVM) dan Artificial Neural Network (ANN), misalnya, dilatih untuk mengklasifikasikan data jaringan sebagai normal atau serangan. Algoritma ML juga sangat efektif dalam menganalisis malware, baik melalui analisis statis terhadap pola kode maupun analisis perilaku dinamis di lingkungan virtual. Bahkan, metode inovatif telah dikembangkan untuk mengubah file menjadi representasi grafis dan menganalisisnya menggunakan teknik deep learning untuk mendeteksi malware.

Meskipun demikian, penggunaan AI dalam keamanan siber menghadirkan sebuah dilema yang kompleks. Materi penelitian menyebutkan AI sebagai “alat ganda” yang dapat digunakan oleh pihak keamanan dan penjahat siber. Penyerang kini menggunakan algoritma AI untuk menciptakan malware yang lebih canggih dan serangan phishing yang lebih meyakinkan. Hal ini menciptakan sebuah “perlombaan senjata” algoritmik yang dinamis, di mana pengembangan algoritma deteksi yang lebih baik selalu ditanggapi dengan pengembangan algoritma serangan yang lebih canggih.

Inovasi Masa Depan dan Tantangan Global

Perkembangan algoritma di masa depan akan didorong oleh beberapa inovasi teknologi yang signifikan. Edge AI akan memungkinkan algoritma machine learning untuk beroperasi langsung pada perangkat, mengurangi ketergantungan pada cloud dan mempercepat pengambilan keputusan. Sementara itu, Komputasi Kuantum menjanjikan kecepatan pemrosesan yang jauh lebih tinggi, memungkinkan pelatihan model ML yang sangat kompleks secara lebih efisien. Selain itu, integrasi algoritma dengan Blockchain menawarkan solusi baru untuk masalah privasi dan keamanan data.

Namun, dengan kemajuan ini, muncul pula tantangan etika dan teknis yang krusial. Salah satu tantangan utama adalah masalah kotak hitam (black box problem), di mana model deep learning yang kompleks seringkali sulit untuk dijelaskan atau diinterpretasikan. Hal ini memunculkan kebutuhan akan Explainable AI (XAI) untuk membangun kepercayaan pengguna, terutama dalam aplikasi kritis seperti kesehatan atau peradilan. Tantangan lainnya adalah bias dalam data, di mana data pelatihan yang tidak seimbang dapat menghasilkan keputusan diskriminatif. Ini menuntut pendekatan yang lebih etis dalam pengumpulan dan pemrosesan data. Terakhir, isu tanggung jawab atas keputusan yang dibuat oleh sistem berbasis ML menjadi tantangan hukum dan etika yang terus diperdebatkan.

Kesimpulan

Algoritma adalah fondasi logis dan sistematis yang universal, berawal dari metode perhitungan kuno yang diformalisasi menjadi prosedur mesin oleh para tokoh kunci dalam sejarah. Meskipun kompleksitas ruang menjadi kurang diperhatikan seiring kemajuan teknologi, analisis efisiensi, terutama kompleksitas waktu, tetap menjadi metrik utama untuk mengevaluasi kinerja algoritma. Di era modern, algoritma adalah kekuatan pendorong di balik revolusi dalam kecerdasan buatan, ilmu data, dan keamanan siber. Namun, pemanfaatan teknologi ini juga menciptakan tantangan baru, termasuk dilema alat ganda, masalah etika, dan perlunya transparansi dalam sistem yang semakin kompleks.

Berdasarkan analisis yang telah dilakukan, direkomendasikan beberapa pendekatan strategis untuk pengembangan dan penerapan algoritma di masa depan:

- Adopsi Pendekatan Holistik: Pengembangan algoritma tidak hanya harus fokus pada akurasi dan kinerja, tetapi juga pada efisiensi, skalabilitas, dan biaya pemeliharaan. Organisasi harus mempertimbangkan semua faktor ini dalam memilih solusi yang paling sesuai.

- Kolaborasi Manusia-Mesin: Terutama dalam bidang keamanan siber, mengandalkan AI semata tidaklah cukup. Kinerja sistem dapat ditingkatkan secara signifikan dengan menggabungkan kemampuan adaptif algoritma pembelajaran mesin dengan keahlian dan analisis dari para profesional manusia.

- Penekanan pada Aspek Etika: Seiring dengan meningkatnya adopsi algoritma di berbagai sektor, penting untuk mengintegrasikan prinsip-prinsip etika ke dalam seluruh siklus pengembangan. Hal ini mencakup memastikan perlindungan privasi data pengguna, membangun model yang transparan dan dapat dijelaskan (explainable), dan secara aktif bekerja untuk menghilangkan bias dalam data yang digunakan untuk pelatihan. Pendekatan yang etis ini sangat penting untuk membangun kepercayaan pengguna dan memastikan bahwa teknologi ini berkembang secara bertanggung jawab.