MLOps: Arsitektur Jembatan Reproduksibel dari Eksperimen AI Menuju Produksi Skala-Hiper dan Real-Time

Disparitas antara Eksperimen AI dan Lingkungan Produksi Skala Besar

Adopsi kecerdasan buatan (AI) telah bergeser dari ranah akademis dan eksperimental menjadi pusat operasi bisnis strategis. Perusahaan teknologi besar kini menggunakan model machine learning (ML) untuk mendorong keputusan bisnis yang sangat penting, seringkali harus dieksekusi dalam waktu nyata (real-time). Misalnya, sebuah perusahaan e-commerce mengintegrasikan model rekomendasi berbasis ML langsung ke platform mereka, menuntut agar rekomendasi personal ditampilkan secara real-time kepada pelanggan. Kebutuhan akan kecepatan, akurasi, dan keandalan operasional pada skala ini menciptakan kesenjangan yang signifikan antara lingkungan pengembangan ilmu data (seringkali berbasis notebook dan manual) dan persyaratan ketat lingkungan produksi TI.

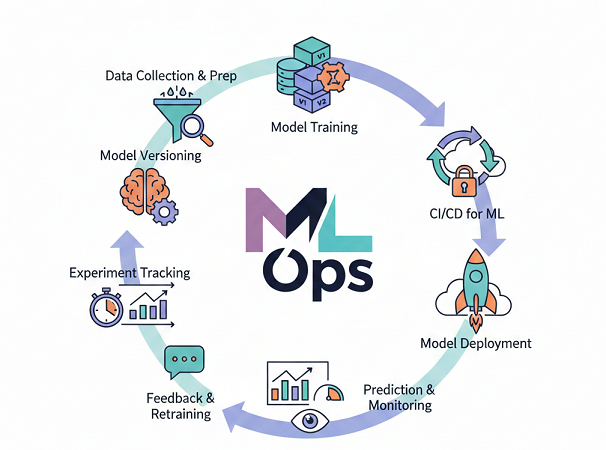

Kesenjangan ini memerlukan pendekatan rekayasa yang terstruktur, yang kemudian dikenal sebagai Machine Learning Operations (MLOps). MLOps bukan sekadar serangkaian alat, melainkan sebuah budaya dan praktik rekayasa yang dirancang untuk menyatukan pengembangan sistem ML (Dev) dengan operasi sistem ML (Ops). Metodologi ini menjadi sangat penting karena semakin banyak organisasi yang mengandalkan model ML untuk membuat keputusan bisnis yang berdampak langsung pada pendapatan dan pengalaman pengguna.

Kegagalan Model Tradisional (MLOps Level 0)

Dalam banyak organisasi, terutama yang baru mulai menerapkan ML, prosesnya berada pada apa yang disebut sebagai MLOps Level 0. Pada level ini, prosesnya sebagian besar manual dan didorong oleh ilmuwan data. Pendekatan manual ini mungkin memadai hanya jika model jarang diubah atau dilatih ulang. Namun, dalam konteks bisnis modern yang bergerak cepat—di mana pola data terus berubah dan pembaruan model diperlukan untuk mempertahankan relevansi—metode ini gagal secara dramatis.

Faktanya, pengalaman di industri menunjukkan bahwa model yang dikembangkan di laboratorium ilmu data seringkali “rusak ketika di-deploy di dunia nyata”. Kegagalan ini jarang disebabkan oleh bug kode perangkat lunak murni (yang telah diatasi oleh DevOps tradisional), tetapi lebih sering disebabkan oleh perubahan data yang tidak terkelola, inkonsistensi lingkungan, atau kurangnya otomatisasi pengujian ujung-ke-ujung. Metodologi DevOps tradisional, yang berfokus terutama pada kode, ternyata tidak memadai untuk sistem ML yang kompleks, di mana kode hanyalah sebagian kecil dari keseluruhan masalah; data, fitur, dan pipeline pelatihan memiliki peran yang sama pentingnya.

Pilar MLOps: Solusi Terstruktur untuk Siklus Hidup ML

MLOps hadir untuk menyelesaikan tantangan yang muncul dari interaksi dinamis antara kode, data, dan model. Tujuan utama MLOps adalah untuk menyederhanakan pembuatan model guna mencapai beberapa hasil bisnis kritis: peningkatan efisiensi, peningkatan akurasi dan kinerja model, percepatan time-to-market, serta jaminan skalabilitas dan tata kelola yang kuat. Dengan mengadopsi MLOps, organisasi memastikan bahwa model ML dikembangkan, diuji, dan di-deploy secara konsisten dan andal.

Penting untuk dipahami bahwa MLOps adalah upaya kolaboratif. MLOps menekankan pemecahan silang (kolaborasi) antara ilmuwan data (yang membangun model), insinyur perangkat lunak (yang membuat pipeline kode), dan operasi TI (yang mengelola infrastruktur produksi). Kolaborasi yang kuat ini mendorong komunikasi yang efektif dan memastikan bahwa setiap pihak yang terlibat memahami keseluruhan proses, yang merupakan prasyarat mutlak untuk keberhasilan deployment AI dalam skala besar.

Implikasi Strategis Awal: Transisi Risiko dari Kode ke Data

Kegagalan MLOps Level 0 sebagian besar disebabkan oleh kesenjangan lingkungan dan kurangnya otomatisasi pengujian. Ketika organisasi mengadopsi MLOps (Level 1 atau 2), otomatisasi integrasi dan deployment infrastruktur kode (Continuous Delivery) cenderung menghilangkan sebagian besar kegagalan deployment yang disebabkan oleh inkonsistensi lingkungan.

Namun, pengamatan arsitektural menunjukkan bahwa keberhasilan dalam mengotomatisasi CI/CD tidak menghilangkan risiko; justru, risiko operasional utama bergeser dari stabilitas kode ke stabilitas dan kualitas data real-time. Karena model ML secara inheren sensitif terhadap data, risiko operasional utama menjadi data drift atau concept drift. Model mungkin di-deploy dengan sempurna dari sudut pandang perangkat lunak, tetapi secara diam-diam mulai memberikan prediksi yang buruk seiring berjalannya waktu. Oleh karena itu, tim MLOps yang matang harus mengalokasikan sumber daya rekayasa mereka pada pembangunan sistem pemantauan dan validasi data yang sangat tangguh, yang berfungsi sebagai benteng pertahanan utama terhadap kegagalan produksi AI yang halus.

Arsitektur Jembatan MLOps: Continuous Integration, Delivery, dan Training (CI/CD/CT)

Penerapan MLOps secara praktis diwujudkan melalui serangkaian pipeline otomatisasi. Tidak seperti DevOps tradisional yang hanya berfokus pada CI/CD, MLOps memperkenalkan pilar ketiga yang krusial: Continuous Training (CT). Otomatisasi ini adalah inti dari operasi ML skala besar.

Continuous Integration (CI) untuk Komponen ML

Continuous Integration (CI) dalam MLOps jauh lebih kompleks daripada CI dalam pengembangan perangkat lunak tradisional. Fokus CI-ML harus mencakup pengujian tidak hanya kode aplikasi, tetapi juga komponen modular, integrasi antara pipeline data, dan konsistensi skema data. Proses ini memastikan bahwa semua artefak yang akan digunakan dalam pelatihan dan deployment telah divalidasi dan siap untuk produksi.

Untuk mendukung CI yang efektif, kode sumber untuk komponen ML harus dimodularisasi agar dapat digunakan kembali dan dikomposisikan di seluruh pipeline ML. Selain itu, komponen-komponen ini idealnya harus ditempatkan dalam container (misalnya, Docker). Penggunaan container memberikan manfaat krusial bagi MLOps:

- Mengisolasi lingkungan eksekusi dari runtime kode kustom.

- Menciptakan kode yang dapat direproduksi antara lingkungan pengembangan dan produksi.

- Memungkinkan setiap komponen dalam pipeline memiliki versi lingkungan runtime, bahasa, dan library yang berbeda.

Komponen kritis yang harus diintegrasikan dan dikelola melalui CI (terutama pada MLOps Level 2) meliputi kontrol sumber, pengujian dan pembangunan layanan, Registri Model, Feature Store, dan ML metadata store.

Continuous Delivery (CD) dan Deployment Pipeline

Continuous Delivery (CD) dalam MLOps juga memiliki definisi yang berbeda secara fundamental. Dalam konteks ML, CD bukan lagi tentang penyaluran satu paket software atau layanan, melainkan deployment dari seluruh sistem—yaitu, pipeline pelatihan ML itu sendiri.

Pada MLOps Level 1, yang di-deploy adalah seluruh pipeline pelatihan yang berjalan secara otomatis dan berulang. Pipeline ini kemudian menyalurkan model terlatih sebagai layanan prediksi (API inferensi online). Langkah deployment model yang menyalurkan model yang telah dilatih dan divalidasi sebagai layanan prediksi harus dilakukan secara otomatis. Fokus CD adalah memastikan infrastruktur inferensi siap menerima model baru dengan intervensi manusia minimal.

Continuous Training (CT): Inti Keunikan MLOps

Continuous Training (CT) adalah properti baru dan unik untuk sistem ML yang membedakan MLOps dari DevOps. CT berkaitan dengan pelatihan ulang dan penyaluran model secara otomatis, yang diperlukan karena model ML rentan terhadap degradasi kinerja seiring waktu akibat perubahan data.

Pipeline CT dioperasionalkan untuk mengotomatisasi proses penggunaan data baru untuk melatih ulang model dalam produksi. Pelatihan ulang ini dapat dipicu oleh beberapa mekanisme :

- Perubahan Kode/Konfigurasi: Perubahan pada kode pelatihan atau hyperparameter.

- Jadwal: Pekerjaan pelatihan ulang otomatis yang berjalan pada interval berkala.

- Data Baru: Ketersediaan data pelatihan baru di lokasi penyimpanan (misalnya, Amazon S3).

- Drift Detection: Pemicu yang paling penting dan event-driven adalah deteksi degradasi kinerja model (model drift).

Untuk menjalankan CT secara andal, pipeline harus memperkenalkan langkah-langkah validasi data dan model otomatis, trigger pipeline, dan pengelolaan metadata.

Model Kematangan MLOps (Level 1 dan Level 2)

Organisasi dapat meningkatkan praktik MLOps secara bertahap untuk mencapai otomatisasi yang lebih tinggi.

MLOps Level 1 (Automated ML Pipeline) merupakan peningkatan signifikan dari Level 0. Karakteristik utamanya meliputi:

- Eksperimen Cepat: Langkah-langkah eksperimen ML diatur dan transisi antar-langkah bersifat otomatis, memungkinkan iterasi yang cepat.

- Simetri Operasional Eksperimental: Implementasi pipeline yang digunakan di lingkungan pengembangan atau eksperimen sama persis dengan yang digunakan di lingkungan praproduksi dan produksi. Ini adalah aspek utama MLOps untuk menyatukan Dev dan Ops.

- CT Model dalam Produksi: Model secara otomatis dilatih dalam produksi menggunakan data baru berdasarkan pemicu pipeline.

MLOps Level 2 melibatkan otomasi penuh CI/CD/CT, memanfaatkan komponen terpusat seperti Feature Store, Registri Model, dan orkestrasi pipeline ML yang matang. Level inilah yang memungkinkan perusahaan teknologi besar mencapai kecepatan dan skalabilitas hiperskala.

Koneksi Arsitektural: CT dan Validasi sebagai Mekanisme Kontrol Kualitas

Untuk mencapai time-to-market yang cepat , perusahaan teknologi besar harus memotong langkah manual yang memakan waktu. CT adalah pendorong kecepatan utama karena memungkinkan model dilatih ulang dan di-deploy secara otomatis tanpa intervensi manual yang lambat.

Namun, kecepatan yang tidak terkontrol akan merusak keandalan. Oleh karena itu, langkah-langkah validasi otomatis (baik validasi data maupun validasi model) yang disematkan di dalam pipeline CT berfungsi sebagai gate kontrol kualitas arsitektur wajib. Validasi otomatis ini memastikan bahwa pipeline otomatis tidak akan pernah menyalurkan model buruk atau model yang dilatih dengan data busuk. Ini adalah prasyarat fungsional yang memastikan bahwa peningkatan efisiensi yang dibawa oleh CT tidak akan mengorbankan konsistensi dan keandalan sistem ML secara keseluruhan.

Table 1: Perbandingan Peran CI, CD, dan CT dalam Siklus Hidup MLOps

| Aspek MLOps | Continuous Integration (CI) | Continuous Delivery (CD) | Continuous Training (CT) |

| Fokus Utama | Menguji dan Membangun Kode/Komponen ML | Otomatisasi Deployment Layanan Prediksi | Otomatisasi Pelatihan Ulang Model |

| Artefak yang Dikelola | Kode, Library, Docker Images, Skema Data | Layanan Prediksi (API), Infrastruktur Inferensi | Model Terlatih, Data Baru, Metadata Pelatihan |

| Pemicu | Perubahan Kode Sumber, Konfigurasi | Model Baru yang Tervalidasi | Data Drift, Jadwal, Data Baru Tersedia |

| Tujuan Output | Komponen ML yang Siap Pakai, Pipeline Build yang Reproduksibel | Layanan Prediksi yang Tersedia untuk Inferensi Latensi Rendah | Model Baru yang Lebih Akurat di Produksi |

Fondasi Keandalan dan Reproduksibilitas (Governance by Design)

Keandalan sistem AI dalam skala besar tidak hanya bergantung pada otomatisasi deployment, tetapi juga pada kemampuan untuk melacak, mengaudit, dan mereproduksi hasil di masa lalu. Aspek ini, yang sering disebut sebagai tata kelola (governance), merupakan inti dari MLOps.

Versioning Data sebagai Tulang Punggung Reproduksibilitas

Salah satu tantangan terbesar dalam ML tradisional adalah ketidakmampuan untuk mereplikasi kinerja model dari beberapa bulan sebelumnya. Hal ini sering terjadi karena tim tidak yakin dataset mana yang tepat yang digunakan untuk pelatihan. MLOps secara tegas mengatasi ini dengan menjadikan data versioning sebagai “tulang punggung machine learning yang dapat direproduksi”.

Versioning data adalah praktik melacak perubahan dalam dataset dari waktu ke waktu. Hal ini sangat penting dalam MLOps untuk memfasilitasi kolaborasi dan memastikan reproduksi hasil yang akurat. Dalam MLOps modern, manajemen versi harus dilakukan secara triaksial, mencakup:

- Versioning Data: Melacak dataset mentah dan fitur yang telah diproses.

- Versioning Kode: Melacak kode pelatihan, preprocessing, dan inferensi.

- Versioning Model: Melacak artefak model biner yang dihasilkan dari pelatihan tertentu.

Selain itu, penting untuk memisahkan kode produktif (seperti preprocessing atau pelatihan) dari kode yang digunakan untuk memuat dan menyimpan versi dataset atau model tertentu untuk menjaga kejelasan alur kerja.

Registri Model: Katalog Pusat untuk Tata Kelola

Registri Model berfungsi sebagai repositori pusat dan katalog untuk semua model yang siap untuk produksi. Alat seperti Amazon SageMaker Model Registry memungkinkan organisasi untuk mengkatalogkan model, mengelola versi model, dan mengaitkan metadata penting, seperti metrik pelatihan, dengan setiap versi.

Fungsi tata kelola Registri Model sangat vital bagi operasi skala besar. Registri secara otomatis mencatat alur kerja persetujuan, yang merupakan aspek penting untuk keperluan audit dan kepatuhan. Dengan menyediakan repositori terpusat, Registri Model memungkinkan tim untuk melacak metadata model dan pengelompokan kasus penggunaan secara efisien.

Pelacakan Silsilah (Lineage Tracking) untuk Kepatuhan Regulasi

Pelacakan silsilah (atau lineage tracking) adalah fitur yang memungkinkan auditabilitas ujung-ke-ujung, yang mendokumentasikan setiap langkah dan artefak yang digunakan dalam siklus hidup ML. Misalnya, Amazon SageMaker ML Lineage Tracking mencatat riwayat pembaruan dan eksekusi pipeline, menciptakan jejak audit yang rinci mulai dari pemrosesan data awal hingga deployment model.

Pelacakan silsilah memiliki dua manfaat operasional utama:

- Debugging Cepat: Pelacakan silsilah mencatat data pelatihan, pengaturan konfigurasi, parameter model, dan gradien pembelajaran. Kemampuan ini memungkinkan insinyur untuk membuat ulang model dan men-debug potensi masalah dengan cepat. Dalam sistem Generative AI yang kompleks, kemampuan tracing ini sangat penting untuk menelusuri respons AI kembali ke komponen sumbernya (kode, data, atau parameter) untuk mengatasi bug atau perilaku tak terduga.

- Kepatuhan dan Audit: Pelacakan silsilah membantu menetapkan tata kelola model dengan mencatat artefak yang diperlukan untuk verifikasi audit dan kepatuhan regulasi.

Implikasi Arsitektural: Tata Kelola sebagai Akselerator, Bukan Hambatan

Perusahaan teknologi besar seringkali tunduk pada persyaratan regulasi yang ketat. Di lingkungan MLOps yang berkecepatan tinggi, di mana deployment model terjadi secara otomatis dan sering, kebutuhan akan auditabilitas bisa menjadi hambatan jika dilakukan secara manual.

Namun, MLOps membalikkan perspektif ini: tata kelola dirancang dan diotomatiskan. Otomatisasi fitur tata kelola, seperti Registri Model untuk persetujuan model otomatis dan Lineage Tracking untuk dokumentasi otomatis setiap run , memungkinkan perusahaan mempertahankan kepatuhan sambil mempertahankan siklus deployment yang cepat. Ini berarti bahwa infrastruktur tata kelola (seperti Registri Model dan Pelacakan Silsilah) harus dianggap sebagai infrastruktur wajib, karena memungkinkan perusahaan untuk memberikan alasan yang jelas, akurat, dan dapat direproduksi mengenai keputusan model tertentu di masa lalu, yang merupakan aspek mendasar dari kepercayaan operasional skala besar.

Mengamankan Produksi Real-Time: Validasi Otomatis dan Pengujian Berkelanjutan

Model ML yang rusak biasanya tidak menunjukkan error perangkat lunak (misalnya, kode 500); sebaliknya, mereka hanya mulai membuat prediksi yang buruk secara diam-diam. Kegagalan yang sunyi ini membuat Continuous Testing dan Validasi Otomatis menjadi sangat penting untuk keandalan produksi real-time.

Validasi Data yang Tegas (Data Validation)

Kualitas data buruk adalah penyebab utama kegagalan model. Oleh karena itu, Data Validation harus menjadi langkah pertama dalam pipeline MLOps, memastikan bahwa data yang masuk divalidasi sebelum pelatihan dimulai.

Validasi data otomatis bertugas memeriksa skema, rentang nilai, jenis data, dan mendeteksi perubahan mendadak dalam distribusi data. Misalnya, jika fitur “customer_age” tiba-tiba mengandung angka negatif, ini harus segera ditandai. Otomatisasi validasi ini membantu mendeteksi masalah data di awal siklus hidup, membandingkan batch data baru dengan baseline data lama, dan mencegah model dilatih dengan data busuk.

Validasi Model Multidimensi

Setelah model dilatih, Model Validation memastikan bahwa model tersebut beroperasi sesuai harapan dan dapat digeneralisasi dengan baik ke data yang belum pernah dilihat. Validasi ini terjadi dalam beberapa dimensi:

- Validasi Kinerja Offline: Membandingkan metrik kinerja model baru (misalnya, precision, recall, atau metrik khusus kasus penggunaan) dengan baseline yang telah ditetapkan. Validasi harus memastikan model memenuhi ekspektasi kinerja dan bertindak sebagai jaring pengaman yang menangkap potensi masalah sebelum deployment.

- Deteksi Bias dan Keadilan: Selain akurasi statistik, MLOps mengharuskan penilaian kinerja model di berbagai kelompok demografi (misalnya, usia, jenis kelamin, wilayah). Mengabaikan bias dapat menyebabkan prediksi yang diskriminatif, yang memiliki implikasi etika serius dan melanggar kepatuhan regulasi.

Pengujian Pipeline dan Integrasi

Model hanyalah satu bagian dari sistem ML. Pipeline MLOps adalah sistem yang menghubungkan data ingestion, preprocessing, serving API, dan monitoring. Pengujian harus diperluas untuk mencakup semua koneksi ini.

Pengujian Pipeline melibatkan menjalankan tes integrasi antara komponen pipeline. Tujuannya adalah memverifikasi bahwa API layanan prediksi berfungsi, respons waktu API memenuhi persyaratan latensi, output model konsisten, dan mekanisme trigger pelatihan ulang bekerja dengan benar. Deployment model ke lingkungan staging memungkinkan verifikasi bahwa integrasi berjalan lancar sebelum masuk ke produksi.

Strategi Deployment Berisiko Rendah (Latensi Rendah)

Untuk memastikan ketersediaan dan performa tinggi selama pembaruan model di lingkungan real-time, MLOps memanfaatkan strategi deployment canggih yang meminimalkan risiko. Setelah model lolos validasi offline, model tersebut harus menjalani validasi online melalui mekanisme deployment yang terkontrol.

Strategi kunci untuk deployment latensi rendah dan berisiko rendah meliputi:

- Shadow Deployment: Model baru di-deploy secara paralel dengan model produksi yang lama (model blue), menerima lalu lintas live, tetapi output prediksinya tidak digunakan. Ini memungkinkan pengujian online kompatibilitas infrastruktur dan performa (latensi) model baru secara aman.

- Canary Deployment: Secara bertahap mengalihkan sebagian kecil lalu lintas (traffic) dari model lama ke model baru (green). Jika metrik pemantauan menunjukkan kinerja yang buruk atau lonjakan latensi, rollback otomatis dapat dipicu untuk memaksimalkan ketersediaan.

- Blue/Green Deployment: Dua lingkungan produksi yang identik (biru untuk model lama, hijau untuk model baru) dijalankan secara paralel. Setelah model baru divalidasi, lalu lintas dialihkan secara penuh. Strategi ini sangat umum dalam pengembangan perangkat lunak dan digunakan dalam MLOps untuk meminimalkan downtime.

Organisasi skala besar harus memilih infrastruktur ML dan opsi deployment yang dioptimalkan untuk performa dan biaya, seperti yang ditawarkan oleh platform cloud terkemuka, untuk memastikan inferensi beperforma tinggi dan berbiaya rendah.

Implikasi: MLOps Membangun “Model Kesehatan” yang Holistik

Pengujian dalam MLOps harus membangun pemeriksaan “kesehatan model” yang holistik. Kegagalan model di produksi tidak hanya berasal dari penurunan akurasi (kegagalan kinerja statistik), tetapi juga dari ketidakmampuan berinteraksi dengan infrastruktur latensi rendah atau melanggar batasan keadilan/bias.

Rangkaian validasi dalam MLOps—termasuk validasi data, validasi model, pengujian pipeline, dan canary deployment —menangkap berbagai kegagalan non-statistik yang tidak akan pernah terdeteksi oleh ilmuwan data di lingkungan eksperimental. Pemeriksaan kesehatan ini harus mencakup metrik ketersediaan endpoint (misalnya, waktu respons API) dan integritas data yang masuk. Untuk perusahaan skala besar yang melayani inferensi real-time, memprioritaskan deployment yang dioptimalkan untuk performa dan biaya (dengan dukungan Blue/Green atau Canary ) sangatlah penting untuk menjamin ketersediaan tinggi dan latensi rendah.

Table 2: Tantangan Produksi AI Skala Besar dan Solusi MLOps yang Relevan

| Tantangan | Implikasi terhadap Bisnis | Praktik MLOps Kunci | |

| Model Drift/Degradasi Kinerja | Keputusan bisnis yang buruk/tidak akurat secara real-time, kerugian finansial | Pemantauan Berkelanjutan (Model Monitor), Continuous Training (CT) Otomatis | |

| Reproduksibilitas dan Auditabilitas | Ketidakmampuan melacak/mereplikasi hasil model lama, risiko kepatuhan | Versioning Data/Model/Kode, Registri Model, Lineage Tracking | |

| Kegagalan Deployment di Real-Time | Gangguan layanan, downtime sistem | Canary/Shadow Deployment, Pipeline Testing, Validasi Model Online | |

| Data Quality Issues | Pelatihan model pada data yang tidak representatif, model yang tidak valid | Data Validation Otomatis (Schema/Distribution Checks) |

Menjaga Kualitas Jangka Panjang: Pemantauan, Deteksi Drift, dan Pelatihan Ulang Otomatis

MLOps berfokus pada pengembangan Sustainable ML Models—model yang dapat beradaptasi secara dinamis terhadap perubahan data dan lingkungan bisnis. Adaptasi ini diorkestrasi melalui pemantauan dan pelatihan ulang otomatis.

Pemantauan Berkelanjutan dan Deteksi Drift

Dalam lingkungan produksi, model akan menghadapi data live yang terus berubah. Seiring waktu, data drift atau concept drift akan menyebabkan degradasi kinerja, memaksa model yang awalnya akurat menjadi tidak efektif. Tanpa pemantauan yang tepat, model akan membuat keputusan yang buruk tanpa peringatan eksplisit.

MLOps mengimplementasikan sistem Continuous Monitoring yang ketat. Alat seperti Amazon SageMaker Model Monitor dirancang untuk terus memantau data dan model yang sedang diproduksi, mendeteksi penyimpangan kinerja, dan mengirim peringatan yang relevan. Pemantauan ini mencakup beberapa aspek:

- Kualitas Prediksi: Melacak metrik kinerja model, seperti akurasi, dan membandingkannya dengan baseline yang ada.

- Integritas Data: Memeriksa penyimpangan antara data live yang diterima oleh model dan data yang digunakan selama pelatihan.

- Bias dan Keadilan: Pemantauan berkelanjutan juga dapat diintegrasikan dengan alat seperti SageMaker Clarify untuk meningkatkan visibilitas terhadap potensi bias yang mungkin muncul dalam model yang berjalan.

Mekanisme Pelatihan Ulang Otomatis (Retraining)

Setelah drift terdeteksi dan dikonfirmasi melampaui ambang batas yang ditentukan, MLOps secara otomatis memicu pipeline pelatihan ulang (Continuous Training). Otomatisasi pelatihan ulang adalah inti dari keberlanjutan model AI.

Tim data dapat mengotomatisasi pelatihan ulang model untuk dilakukan lebih sering dan pada interval yang lebih pendek—baik melalui penjadwalan teratur atau melalui pemicu event-driven. Siklus pemeliharaan model MLOps mencakup serangkaian langkah yang terus berulang : Melatih model, Memvalidasi model (untuk memastikan kinerja yang membaik), Menyebarkan model (menggunakan strategi berisiko rendah), Melayani Inferensi (batch atau streaming), Pembuatan Profil Data (untuk mendeteksi perubahan), dan akhirnya Pelatihan Ulang. Otomatisasi alur kerja ini memastikan bahwa model selalu optimal terhadap kondisi dunia nyata saat ini.

Integrasi Platform untuk Keberlanjutan

Keberhasilan dalam pemantauan dan pelatihan ulang otomatis bergantung pada orkestrasi pipeline yang kuat. Layanan seperti Amazon SageMaker Pipelines memungkinkan orkestrasi alur kerja ML menyeluruh, yang dapat dikonfigurasi untuk berjalan secara otomatis berdasarkan peristiwa tertentu (misalnya, data pelatihan baru yang muncul). Menerapkan praktik MLOps secara bertahap dengan integrasi platform seperti ini membantu organisasi mengatasi perubahan cepat pada data dan lingkungan bisnis, memastikan sistem ML tetap up-to-date dan relevan.

Implikasi Fungsional: Model Sebagai Kontrak Bisnis yang Dinamis

Model AI yang di-deploy dalam MLOps harus diperlakukan sebagai kontrak bisnis yang dinamis. Kontrak ini menetapkan tingkat akurasi atau kinerja minimum yang dijamin. Ketika pemantauan berkelanjutan menunjukkan bahwa kinerja model telah turun di bawah ambang batas kritis (misalnya, karena drift), kontrak tersebut dianggap dilanggar.

Dalam arsitektur MLOps yang matang, drift bukan hanya kegagalan yang perlu dicatat; ia adalah event bisnis yang secara otomatis memicu pipeline CT untuk memitigasi risiko dan menjalankan pemulihan (pelatihan kontrak baru). Proses event-driven ini memastikan bahwa respons terhadap degradasi model cepat, otomatis, dan terukur, memungkinkan perusahaan teknologi besar mempertahankan keunggulan kompetitif real-time mereka.

Implementasi dan Tata Kelola AI di Perusahaan Teknologi Tinggi: Studi Kasus Platform

Perusahaan teknologi tinggi mengoperasionalkan AI dalam skala masif memerlukan alat yang dibuat khusus dan terintegrasi secara vertikal, di mana platform MLOps end-to-end menjadi solusi standar.

Solusi Platform Terpadu

Platform MLOps yang terkemuka, seperti Amazon SageMaker, menyediakan alat yang dibuat khusus untuk operasi machine learning (MLOps). Platform ini memungkinkan organisasi mengotomatisasi dan menstandarkan proses di seluruh siklus hidup ML untuk pengiriman model produksi beperforma tinggi dengan cepat dan dalam skala besar.

Keunggulan utama solusi platform terpadu untuk skala besar meliputi:

- Integrasi CI/CD ML: Mengintegrasikan alur kerja ML dengan pipeline CI/CD untuk produksi dengan waktu yang lebih cepat.

- Alur Kerja Model yang Efisien: Menciptakan alur kerja pelatihan yang berulang dan cepat.

- Tata Kelola ML Terpusat: Menyediakan katalog artefak ML terpusat yang mendukung reproduksi dan audit.

- Pemantauan Kualitas Berkelanjutan: Terus memantau data dan model dalam produksi untuk menjaga kualitas prediksi.

Studi Kasus Otomasi dan Skala

Penggunaan MLOps memungkinkan otomatisasi yang diperlukan untuk melayani kasus penggunaan real-time yang kompleks. Sebagai contoh, perusahaan e-commerce mengimplementasikan pipeline CI/CD yang memungkinkan pembaruan model rekomendasi otomatis. Model ini kemudian diintegrasikan dengan platform mereka untuk menampilkan rekomendasi personal kepada pelanggan secara real-time, sebuah pendorong pendapatan yang krusial.

Platform modern mendukung otomatisasi ini melalui komponen orkestrasi dan standarisasi lingkungan:

- Orkestrasi dengan Pipelines: Amazon SageMaker Pipelines mengotomatisasi alur kerja ML menyeluruh—mulai dari pemrosesan data, pelatihan, penyempurnaan, evaluasi, hingga deployment.

- Standarisasi Lingkungan: SageMaker Projects menawarkan templat yang langsung menyediakan lingkungan ilmuwan data berstandar dengan alat, pustaka teruji, repositori kontrol sumber, dan pipeline CI/CD bawaan. Ini meningkatkan produktivitas ilmuwan data dan kecepatan inovasi dengan mengurangi gesekan antara lingkungan pengembangan dan produksi.

- Optimasi Inferensi: Platform ini menyediakan pilihan infrastruktur dan opsi deployment (seperti Blue/Green deployment) untuk menghasilkan inferensi beperforma tinggi, latensi rendah, dan berbiaya rendah, yang penting untuk memenuhi tuntutan real-time.

Memastikan Tata Kelola dan Kepatuhan

Tata kelola pada skala perusahaan dicapai dengan menetapkan infrastruktur sebagai kode (IaC) dan melacak silsilah semua artefak. SageMaker Projects memungkinkan pengguna untuk mendefinisikan infrastruktur ML melalui kode menggunakan file template, menjamin lingkungan yang direproduksi.

Selain itu, Pelacakan Silsilah (Lineage Tracking) mencatat jejak audit dari data pelatihan, pengaturan konfigurasi, dan model yang dihasilkan, memastikan bahwa proses audit dan kepatuhan dapat dilalui. Registri Model mencatat alur kerja persetujuan dan melacak versi, memastikan bahwa hanya model yang disetujui yang dapat mencapai produksi.

Implikasi Strategis: Keharusan Integrasi Vertikal

Mengoperasionalkan AI dalam skala hiperskala memerlukan manajemen puluhan hingga ratusan model secara bersamaan. Mengatasi masalah teknis atau bisnis yang muncul selama siklus hidup model membutuhkan serangkaian alat yang kohesif.

Menggunakan alat yang terpisah (misalnya, satu untuk versioning data, satu untuk eksperimen, satu untuk orkestrasi, dan satu untuk pemantauan) menimbulkan overhead integrasi yang sangat besar dan memperlambat time-to-market. Perusahaan teknologi besar menyadari bahwa platform terpadu (yang menyatukan pelacakan eksperimen menggunakan MLflow, orkestrasi dengan Pipelines, dan tata kelola dengan Model Registry ) sangat penting. Strategi integrasi vertikal ini secara signifikan mengurangi engineering effort yang diperlukan untuk memelihara pipeline, memungkinkan tim fokus pada inovasi dan peningkatan kinerja model itu sendiri, yang pada akhirnya memastikan keandalan pada skala masif.

Kesimpulan

MLOps adalah metodologi krusial yang berhasil menjembatani kesenjangan antara fase eksperimen ilmu data (Dev) dan fase operasi produksi skala besar (Ops). Transformasi dari proses manual Level 0 yang rentan gagal, menjadi alur kerja otomatis Level 2, berpusat pada tiga pilar utama: Continuous Integration (CI), Continuous Delivery (CD), dan Continuous Training (CT).

Keberhasilan perusahaan teknologi besar dalam menerapkan model AI secara real-time dan andal bersumber dari kemampuan MLOps untuk mengendalikan tiga variabel utama yang unik bagi sistem ML:

- Otomatisasi Penuh Pipeline (CT): Memastikan bahwa model secara otomatis dilatih ulang dan disalurkan sebagai respons terhadap data baru atau model drift.

- Tata Kelola Berbasis Rekayasa: Mencapai reproduksibilitas melalui versioning triaksial (data, kode, model) dan auditabilitas melalui Registri Model dan Pelacakan Silsilah.

- Mitigasi Risiko Deployment: Memastikan ketersediaan dan performa real-time melalui validasi model online dan strategi deployment berisiko rendah seperti Canary dan Shadow.

MLOps mengubah AI dari proyek yang rapuh dan berbasis penemuan menjadi produk rekayasa yang terkelola, terukur, dan berkelanjutan.

Berdasarkan analisis arsitektural dan praktik terbaik perusahaan teknologi tinggi, laporan ini memberikan rekomendasi strategis berikut untuk mengoperasionalkan AI pada skala masif:

- Prioritaskan Tata Kelola Otomatis (Governance by Design): Investasi harus diarahkan pada implementasi Registri Model dan Lineage Tracking sejak tahap awal. Otomatisasi fitur audit ini akan membangun fondasi kepatuhan dan kemampuan menjelaskan yang diperlukan untuk mempertahankan kecepatan deployment tinggi di masa depan, alih-alih membiarkan tata kelola menjadi hambatan.

- Terapkan Simetri Operasional melalui Containerization: Pastikan lingkungan eksperimental, staging, dan produksi menggunakan implementasi pipeline yang identik. Containerization kode termodulasi adalah wajib untuk menghilangkan kegagalan deployment yang disebabkan oleh inkonsistensi lingkungan.

- Fokuskan Sumber Daya pada Pemantauan Data: Mengingat bahwa risiko operasional utama bergeser dari kode ke data, sumber daya rekayasa terkemuka harus dialokasikan untuk Continuous Monitoring dan Data Validation yang ketat. Metrik drift harus diidentifikasi sebagai event bisnis yang secara otomatis memicu pipeline CT, memastikan pemulihan cepat dan self-healing sistem.

- Pilih Platform MLOps Terpadu: Adopsi platform end-to-end yang menawarkan otomatisasi menyeluruh (CI/CD/CT) dan kemampuan tata kelola bawaan. Hal ini mengurangi overhead integrasi yang masif dan memungkinkan tim fokus pada peningkatan inovasi model.

Seiring dengan meningkatnya kompleksitas model, terutama adopsi model Generative AI dan sistem berbasis prompt, kebutuhan akan auditabilitas akan menjadi lebih intens. Di masa depan, MLOps akan semakin membutuhkan sistem tracing canggih untuk menelusuri rantai permintaan (misalnya, dalam aplikasi RAG atau rantai agen AI) kembali ke model dasar (foundation model) dan data fine-tuning yang digunakan. Hal ini akan semakin menekankan peran sentral Lineage Tracking dan metadata store dalam memastikan transparansi, keandalan, dan kepatuhan dalam ekosistem AI yang semakin dinamis.